本文借鉴了:Java并发之基石篇、死磕Synchronized底层实现等文章,并做了一些修改,仅作为个人的学习笔记。非常感谢createchance、wangzhi等作者的分享

导读

声明:本文所有的分析内容基于 OpenDK 的 Java 11 版本的 HotSpot JVM 源代码。

在阅读本文之前,你需要:

- 了解 Java 中的基本的线程使用方式以及注意点

- 了解 Java 中的基本线程间通讯的方式

- 了解 Java 中的 volatile 的基本语义

- 了解 C/C++ 编程

- 了解 JNI 的相关开发知识

- 了解一些 x86 的汇编(仅仅是很简单的内容,要求能读懂)

本文重点分析内容:

- 共享内存多核系统基本架构与设计

- Java 内存模型设计

- Java Thread 的创建与停止

- Java synchonized 的实现机制

- Java Object 的 wait 和 notify/notifyAll 实现机制

- Java volatile 关键字的实现方式

阅读建议:

- 下载一份 HotSpot JVM 11 的代码,了解基本代码架构,并且本地能够编译和调试,如何编译或者调试可以参考 OpenJDK wiki 或者 周志明的《深入理解 Java 虚拟机:第二版》一书

- 使用你熟悉的 IDE 导入 JVM 的源码,建议使用 eclipse CDT,其他的 IDE 笔者都觉得不是很方便

- 在阅读的过程中,不能仅仅看本文的分析,需要结合起来,自己下断点或者打印日志调试,并且不断反复尝试,反复理解核心代码片段

- 最后一点建议,现代 JVM 的实现非常复杂,会涉及到很多的操作系统、算法、硬件、统设计以及性能调优等等方便的知识,所以在阅读源码的时候千万不要深入无关代码的细节部分,否则你会陷于无边无际的代码海洋而无法自拔~

本文非常长,笔者写了一个多星期,纯属手打,文中的观点和分析均是本人经过反复的试验和分析得出的,同时借鉴了很多网络上的文章,这些借鉴的内容已经放到文末的参考资料中,在此非常感谢这些作者的分享。真心希望你可以认真读完,我敢保证,只要你认真读完,肯定收获很多,加油~

概要

并行是这个时代的主旋律,也是很多现代操作系统需要提供的必备功能。在过去摩尔定律催生下,单个 CPU 核心计算的速度越来越快。但是随着产业的发展,单个CPU核心的计算上限已经难以突破,传统的加强单核的思维模式已经不能满足需求。在古代,人们需要强大的战马驱动战车,为了能够使得战斗力越来越强,人们驯化出了越来越强劲的战马,但是单匹马的力量始终是有限的,因此人们发明了多马并驾的战车结构,大量出现的多乘战车产催生了强大的万乘之国。同样地,在现代计算机领域,人们在单个 CPU 核心能力有限的情况下,使用多个核心的 CPU 进行并行计算,以驱动强大的算力。

但是,多 CPU 和多战马是远远不同的,在现实世界中的计算任务大多需要互相协调,其根本原因是人类的思维方式就是线性串行的,设计一个完全并行的计算逻辑体系还是有相当大难度的。

如何设计一个高并发的程序,不仅仅是工程界的难题,在计算机学术界也是一个需要不断突破的研究领域。从学术理论提出,到算法设计,再到工程实施,再到产业验证调优,整个流程都需要比较长的时间来进行迭代,究其根本,并行计算本身就是非常复杂、不确定的、不可预测的逻辑系统。

多核系统中的一致性

号称一次编写,到处运行的 Java,其本身也是构建在不同的系统之上的,以其运行时 JVM 来屏蔽系统底层的差异。因此,在介绍 Java 并发体系之间,有必要简要介绍下计算机系统层面上的并发,以及面对的问题。

我们的目的其实很简单,就是让计算机在同一时刻,能够运行更多的任务。而并行计算,提供了非常不错的解决方案。虽然这看起来很自然,但实际上面临着众多的问题,其中一个重大的问题就是绝大多数的计算不仅仅是 CPU 自己的事,而是需要很多计算机系统部件共同参与。但是我们知道,计算机系统中运行速度最快就是 CPU,其他部件例如:内存、磁盘、网络等等都是及其缓慢的,同时这些操作在目前的计算机体系中是很难消除的,因为我们不可能仅仅靠寄存器就完成所有的计算任务。面对高速 CPU 和低速存储之间的鸿沟,如果想要实现高效数据通讯,一个良好的解决方案就是在它们之间添加一个 cache 层,这个 cache 层的速度和整体的速度关系如下:

CPU --> cache --> 存储

通过 cache 这个缓冲地带,实现 CPU 和存储之间的高效「对话」。这是计算机和软件领域通用的一个问题解决方案:增加中间层。没有什么问题是一个中间层解决不了的,如果有,那就两层。在运算的时候,CPU 将需要使用到的数据复制到 Cache 中,以后每次获取数据都从较为快速的 cache 中获取,加快访问速度。

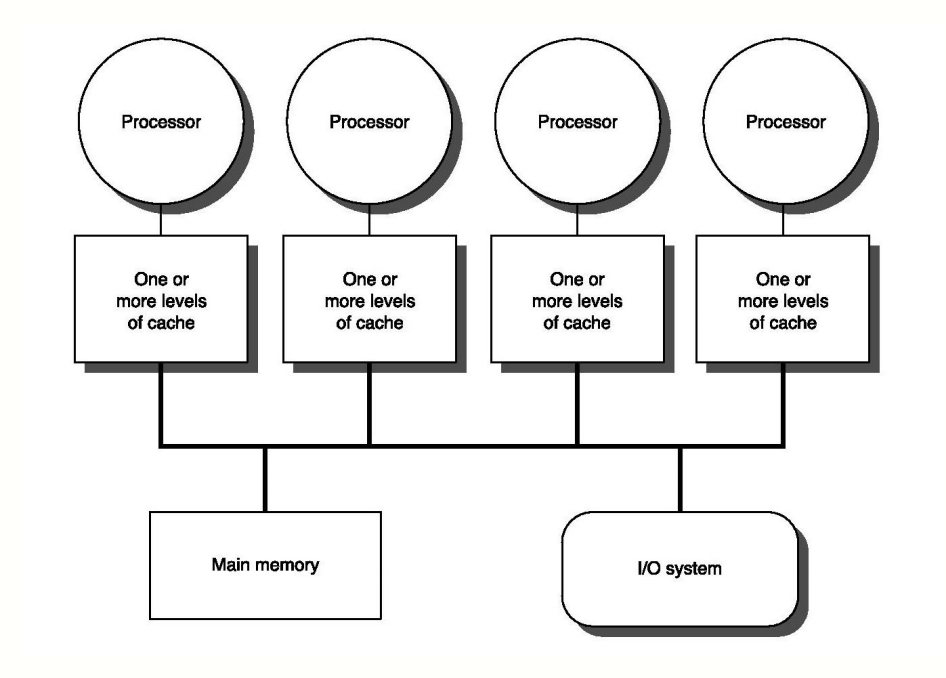

所谓理想很丰满,现实很骨感。这种计算体系有一个重要的问题需要解决,那就是:缓存一致性(cache coherence)问题。在现代的计算机系统中,主要都是多核系统为主。在这些计算机系统中,每一个 CPU 都拥有自己独立的高速缓存,但是因为主存只有一个,因此它们之间只能共享,这种系统也称为:共享内存多核系统(Shared-Memory multiprocessors System),如下图所示:

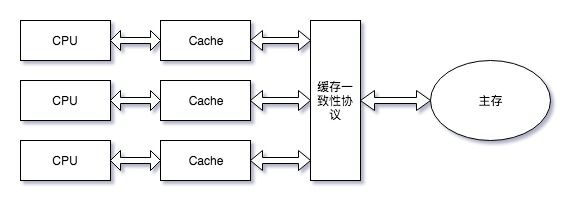

因此,当多个处理器同时需要访问同一个内存区域的数据时,首先回去访问 CPU 的 cache 区域中的数据,但是 cache 中的数据也是从共享内存中获取的,此时如果别的 CPU 修改了 cache 中的数据,那么就造成了数据不一致的问题了。因此,如果发生了这种「数据竞态」的问题,到底该以哪个数据为准呢?此时,我们需要一个一致性协议来保证。各个 CPU 在操作的时候都需要遵守缓存一致性协议来进行操作,这类型的协议有很多,例如:MSI、MESI、MOSI、Synapse、Firefly 以及 Dragon Protocol 等等。所以,通常情况下,共享内存多核系统的架构如下所示:

除了使用高速 cache 来缓和 CPU 和存储设备之间的速度鸿沟,为了能够充分利用多核 CPU 的处理性能,处理在实际执行机器指令时并不一定会按照程序设定的指令顺序执行,可能存在代码乱序执行(Out-Of-Order Execution)优化。注意,这里虽然乱序执行了,但是系统会保证执行的结果逻辑上的正确的,从宏观上看就好像是顺序执行一样。举个例子,比如我们有如下代码:

int a = value1;

int b = value2;

这两句话实际的执行顺序可能是先赋值 a 然后赋值 b,但是也可能反过来,反正这两句话执行完毕之后 a 和 b 的值都被赋值上了就可以,这里对外表现为顺序串行执行,这其实就是 as-serial 协议保证的。为什么需要这样?一方面这两句话本身并没有什么逻辑上的依赖性,完全可以并行执行;另一方面,如果我们傻傻地按照顺序执行的话,在执行第一句话的时候,我们可能需要从主存中读取 value1 的值,这种操作对于 CPU 来讲是及其缓慢的操作,如果我们顺序执行的话,那么就只能等待 value1 值读取成功之后才能继续执行下面的指令,这样就造成了 CPU 的空等待,白白浪费了资源。

Java 内存模型

上面我们探讨了共享内存多核系统的内存模型,我们提到了高速缓存以及缓存一致性问题,同时还介绍了指令乱序执行的问题。其实,这些概念在 Java 中也是存在的。因为 Java 的目标是:一次编写,到处运行。每一个计算机系统或者操作系统都会有自己特殊的内存模型,如果 Java 想要实现一次编写到处运行的目标,就必须在 JVM 层面上将系统之间的差异屏蔽掉。面对如此多的系统,最好的方式就是定义一套 Java 自己的内存访问模型,然后在不同的硬件平台和操作系统上分别利用本地接口来实现。这里的思想其实和增加 cache 是一样的,通过增加中间层来解决系统差异带来的协作问题。

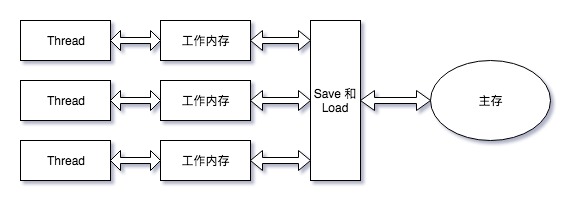

Java 在 1.5 版本中引入了 JSR 133 标准,这个标准提出了 Java 中的并发内存模型和线程规范,这个标准的发布标志着 Java 拥有独立于系统平台的并发内存模型。和 C/C++不同的是,Java 并没有直接操作系统平台中的内存模型,而是自己定义了一套机制,这套机制包含了并发访问机制、缓存一致性协议以及指令重排序解决方案等内容。在 JSR 133 标准中,定义了如下的 Java 并发内存模型:

可以看到,这里的内存模型和上面讲到的计算机系统中的内存模型是十分类似的。在 JVM 中,并发的最小单位是 Thread,在不考虑 JVM 线程实现细节上,可以简单认为一个 Thread 对应一个内核线程,这样就可以进而认为 Thread 对应一个 CPU 核心。这里需要注意的是,工作内存和 Java 内存区域中的堆、栈或者方法区(java 和 native)等并不是一个层面上的东西,它们之间也没有直接的对应关系。同时,很多人会误以为这里的工作内存其实就是 TLAB (thread local allocation buffers),字面上看起来很像,但是没有任何关系的。

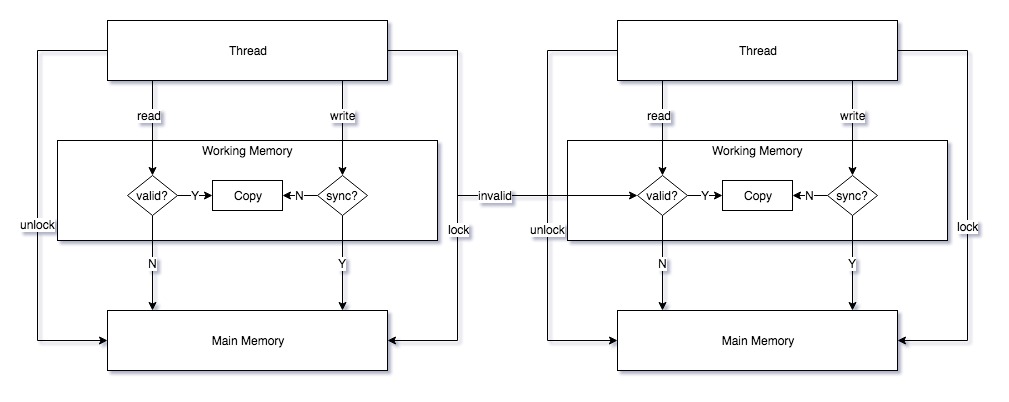

从上面的图中,可以看出每个线程的工作内存和主存之间的一致性保证是通过 save 和 load 等等一系列的操作完成的。JSR 133 早期版本中定义了 8 种操作(早期版本的描述可以参考:Thread and Locks),但是后来处于描述简化以及方便不同 JVM 实现修为了 4 种操作,但是只是描述上的修改,内存模型基本设计并没有改变(周志明的书中有描述,感谢这本书的指点)。这里我们采用最新版本的 4 种操作来描述,这种方式比较清晰易懂。这 4 种操作和 Java 内存模型的对应关系如下图:

下面分别介绍下上面图中涉及的 4 种操作:

- read:Java 执行引擎访问本地工作内存中的变量副本,如果变量副本无效(变量副本不存在也是无效的一种),那就去主存中获取,同时在本地工作内存中缓存一份

- write:Java 执行引擎将最新的变量值赋值给工作内存中的变量副本,同时需要判断是否需要将这个新的值立即同步给主内存,如果需要同步的话,还需要配合 lock 操作

- lock:Java 执行引擎将主内存中的变量锁定,锁定的含义有:其他的线程在此之后不能访问这个变量直到本线程 unlock;一旦锁定,其他线程针对这个变量的操作必须等待

- unlock:Java 执行引擎将主内存中的变量解锁,解锁之后才能:各个线程并发访问这个变量;某个线程再次锁定

Java Thread 创建

在 Java 中,我们都知道,一个线程直接对应了一个 Thread 类对象。创建和启动一个线程是比较容易的,我们只需要创建一个 Thread 对象,然后调用对象的 start 方法即可。但是在创建一个 Thread 对象和启动线程 JVM 中究竟发生了什么?本节我们就来看下。

如果你仔细看过 Thread 类的源码就知道,在创建一个 Thread 对象的时候,除了一些初始化设置之外就没有什么实质性的操作,真正的工作其实是在 start 方法调用中产生的。也就是说,只是创建了一个 Thread 对象和创建一个普通的 Java 对象没什么实质性的差异。因此我们需要看下在 HotSpot 11 中的 Thread start 实现,那么怎么找实现的代码呢?打开 Thread 类的代码,在这个类开始的地方我们看到了如下的代码:

/* Make sure registerNatives is the first thing <clinit> does. */

private static native void registerNatives();

static {

registerNatives();

}

如果你熟悉 JNI 的话,就知道这里的 registerNatives 方法就是将 Thread 类中的 java 方法和一个本地的 C/C++ 函数进行对应,同时由于这个方法是类加载的时候调用的,因此在类首次加载的时候(Bootstrap 类加载)就会注册这些 native 方法,那么 Thread 中都有哪些 native 方法呢?看下 Thread 类的结尾处(JDK 源码中一般都是将 native 方法声明在类的结尾处,方便查找):

public static native Thread currentThread();

public static native void yield();

public static native void sleep(long millis) throws InterruptedException;

private native void start0();

private native boolean isInterrupted(boolean ClearInterrupted);

public final native boolean isAlive();

public native int countStackFrames();

public static native boolean holdsLock(Object obj);

private static native StackTraceElement[][] dumpThreads(Thread[] threads);

private static native Thread[] getThreads();

private native void setPriority0(int newPriority);

private native void stop0(Object o);

private native void suspend0();

private native void resume0();

private native void interrupt0();

private native void setNativeName(String name);

这些方法,不用说你肯定非常熟悉,这里就不赘述了。

在进入代码量及其巨大且复杂的 OpenJDK 之前有几点想说明下:

- 所有用的源代码都是从 OpenJDK 官方下载的 HotSpot JVM 代码,版本 11

- 分析的时候我会将代码中的注释一起放上来,方便大家阅读

- 分析的时候,我们只关注重点的代码,也就是核心功能代码,细节暂时不会关心

好的,现在我们打开 OpenJDK 11 的代码(至于下载源码,请参考 OpenJDK wiki;使用什么 IDE 打开全看你的心情,我是使用 eclipse cdt),全局搜索如下内容:

java_lang_Thread_registerNatives

什么?你问我为啥搜这个?如果你有这个疑问的话,可以先看下 JNI 的内容~这里简单地说下,这种内容是 JNI 默认的java 方法和 native 方法对应的方式,JVM 运行的时候会通过这种方式查找本地符号表中的符号的符号,然后直接跳转过去~

我们搜索之后可以看到在src/java.base/share/native/libjava/Thread.c中定了这个函数:

static JNINativeMethod methods[] = {

{"start0", "()V", (void *)&JVM_StartThread},

{"stop0", "(" OBJ ")V", (void *)&JVM_StopThread},

{"isAlive", "()Z", (void *)&JVM_IsThreadAlive},

{"suspend0", "()V", (void *)&JVM_SuspendThread},

{"resume0", "()V", (void *)&JVM_ResumeThread},

{"setPriority0", "(I)V", (void *)&JVM_SetThreadPriority},

{"yield", "()V", (void *)&JVM_Yield},

{"sleep", "(J)V", (void *)&JVM_Sleep},

{"currentThread", "()" THD, (void *)&JVM_CurrentThread},

{"countStackFrames", "()I", (void *)&JVM_CountStackFrames},

{"interrupt0", "()V", (void *)&JVM_Interrupt},

{"isInterrupted", "(Z)Z", (void *)&JVM_IsInterrupted},

{"holdsLock", "(" OBJ ")Z", (void *)&JVM_HoldsLock},

{"getThreads", "()[" THD, (void *)&JVM_GetAllThreads},

{"dumpThreads", "([" THD ")[[" STE, (void *)&JVM_DumpThreads},

{"setNativeName", "(" STR ")V", (void *)&JVM_SetNativeThreadName},

};

JNIEXPORT void JNICALL

Java_java_lang_Thread_registerNatives(JNIEnv *env, jclass cls)

{

(*env)->RegisterNatives(env, cls, methods, ARRAY_LENGTH(methods));

}

可以看到,在 registerNatives 函数中,向虚拟机注册了很多的本地方法,基本就是上面我们提到的 Thread 中的所有 native 方法。JNINativeMethod 这是个函数指针,定义在 JNI 中,内容如下:

/*

* used in RegisterNatives to describe native method name, signature,

* and function pointer.

*/

typedef struct {

char *name;

char *signature;

void *fnPtr;

} JNINativeMethod;

现在,我们知道了,第一列是 Java 中定义的 native 方法名称,第二列是 Java 方法签名,第三列是本地方法对应函数。因此,Java 中的 start 方法就是对应 native 的 JVM_StartThread 函数:

JVM_ENTRY(void, JVM_StartThread(JNIEnv* env, jobject jthread))

JVMWrapper("JVM_StartThread");

JavaThread *native_thread = NULL;

// We cannot hold the Threads_lock when we throw an exception,

// due to rank ordering issues. Example: we might need to grab the

// Heap_lock while we construct the exception.

bool throw_illegal_thread_state = false;

// We must release the Threads_lock before we can post a jvmti event

// in Thread::start.

{

// Ensure that the C++ Thread and OSThread structures aren't freed before

// we operate.

MutexLocker mu(Threads_lock);

// Since JDK 5 the java.lang.Thread threadStatus is used to prevent

// re-starting an already started thread, so we should usually find

// that the JavaThread is null. However for a JNI attached thread

// there is a small window between the Thread object being created

// (with its JavaThread set) and the update to its threadStatus, so we

// have to check for this

if (java_lang_Thread::thread(JNIHandles::resolve_non_null(jthread)) != NULL) {

throw_illegal_thread_state = true;

} else {

// We could also check the stillborn flag to see if this thread was already stopped, but

// for historical reasons we let the thread detect that itself when it starts running

jlong size =

java_lang_Thread::stackSize(JNIHandles::resolve_non_null(jthread));

// Allocate the C++ Thread structure and create the native thread. The

// stack size retrieved from java is 64-bit signed, but the constructor takes

// size_t (an unsigned type), which may be 32 or 64-bit depending on the platform.

// - Avoid truncating on 32-bit platforms if size is greater than UINT_MAX.

// - Avoid passing negative values which would result in really large stacks.

NOT_LP64(if (size > SIZE_MAX) size = SIZE_MAX;)

size_t sz = size > 0 ? (size_t) size : 0;

// 重点看这里!!!

native_thread = new JavaThread(&thread_entry, sz);

// At this point it may be possible that no osthread was created for the

// JavaThread due to lack of memory. Check for this situation and throw

// an exception if necessary. Eventually we may want to change this so

// that we only grab the lock if the thread was created successfully -

// then we can also do this check and throw the exception in the

// JavaThread constructor.

if (native_thread->osthread() != NULL) {

// Note: the current thread is not being used within "prepare".

native_thread->prepare(jthread);

}

}

}

if (throw_illegal_thread_state) {

THROW(vmSymbols::java_lang_IllegalThreadStateException());

}

assert(native_thread != NULL, "Starting null thread?");

if (native_thread->osthread() == NULL) {

// No one should hold a reference to the 'native_thread'.

native_thread->smr_delete();

if (JvmtiExport::should_post_resource_exhausted()) {

JvmtiExport::post_resource_exhausted(

JVMTI_RESOURCE_EXHAUSTED_OOM_ERROR | JVMTI_RESOURCE_EXHAUSTED_THREADS,

os::native_thread_creation_failed_msg());

}

THROW_MSG(vmSymbols::java_lang_OutOfMemoryError(),

os::native_thread_creation_failed_msg());

}

Thread::start(native_thread);

JVM_END

上面代码本身并不多,并且有很多的注释,这样我们就能很好地理解这段代码了。我们要关注的重点是这一行:

native_thread = new JavaThread(&thread_entry, sz);

这里创建了一个 JavaThread 对象,并且给了两个参数,第一个暂且不管,后面我们会重点说明,第二个是 stack size,也就是每一个线程的栈大小,这个参数可以在创建 Thread 对象的时候指定,也可以添加 JVM 启动参数:Xss(设定每个线程的堆栈大小)。进去看下:

JavaThread::JavaThread(ThreadFunction entry_point, size_t stack_sz) :

Thread() {

initialize();

_jni_attach_state = _not_attaching_via_jni;

set_entry_point(entry_point);

// Create the native thread itself.

// %note runtime_23

os::ThreadType thr_type = os::java_thread;

thr_type = entry_point == &compiler_thread_entry ? os::compiler_thread :

os::java_thread;

// 通过 os 类的 create_thread 函数来创建一个线程

os::create_thread(this, thr_type, stack_sz);

// The _osthread may be NULL here because we ran out of memory (too many threads active).

// We need to throw and OutOfMemoryError - however we cannot do this here because the caller

// may hold a lock and all locks must be unlocked before throwing the exception (throwing

// the exception consists of creating the exception object & initializing it, initialization

// will leave the VM via a JavaCall and then all locks must be unlocked).

//

// The thread is still suspended when we reach here. Thread must be explicit started

// by creator! Furthermore, the thread must also explicitly be added to the Threads list

// by calling Threads:add. The reason why this is not done here, is because the thread

// object must be fully initialized (take a look at JVM_Start)

}

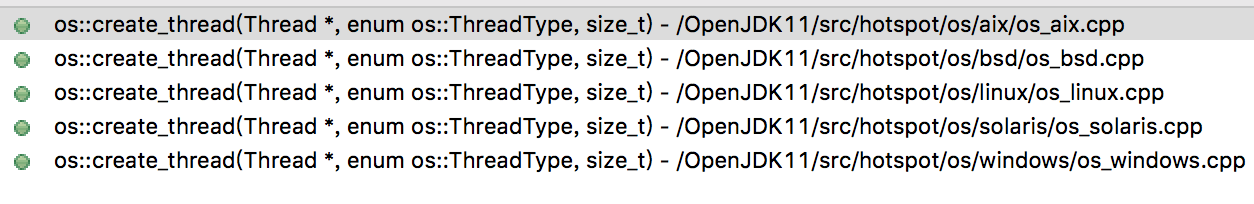

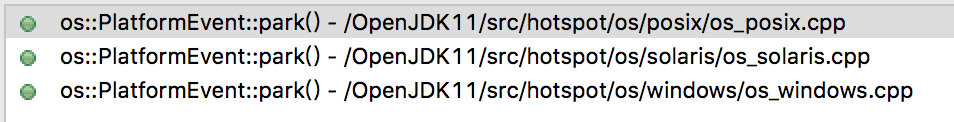

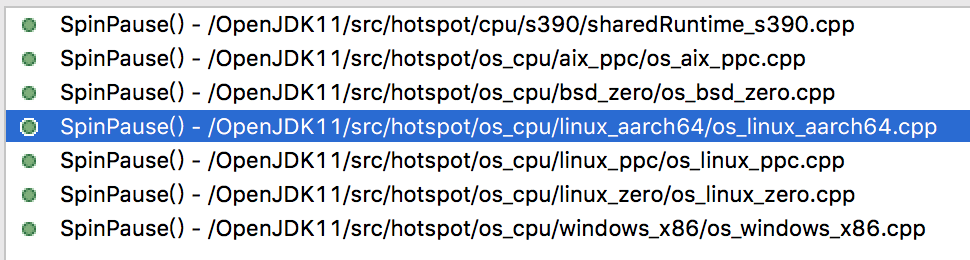

可以看到,重点是通过 os 类的 create_thread 函数来创建一个线程,因为 JVM 是跨平台的,并且不同操作系统上的线程实现机制可能是不一样的,因此这里的 create_thread 肯定会有多个针对不同平台的实现,我们查看这个函数的实现就知道了:

可以看到,HotSpot 提供了主要的操作系统上的实现,因为在服务器上,linux 的占比是很高的,因此我们这里就看下 linux 上的实现即可:

可以看到,HotSpot 提供了主要的操作系统上的实现,因为在服务器上,linux 的占比是很高的,因此我们这里就看下 linux 上的实现即可:

bool os::create_thread(Thread* thread, ThreadType thr_type,

size_t req_stack_size) {

...

// init thread attributes

pthread_attr_t attr;

pthread_attr_init(&attr);

pthread_attr_setdetachstate(&attr, PTHREAD_CREATE_DETACHED);

// Calculate stack size if it's not specified by caller.

size_t stack_size = os::Posix::get_initial_stack_size(thr_type, req_stack_size);

// In the Linux NPTL pthread implementation the guard size mechanism

// is not implemented properly. The posix standard requires adding

// the size of the guard pages to the stack size, instead Linux

// takes the space out of 'stacksize'. Thus we adapt the requested

// stack_size by the size of the guard pages to mimick proper

// behaviour. However, be careful not to end up with a size

// of zero due to overflow. Don't add the guard page in that case.

size_t guard_size = os::Linux::default_guard_size(thr_type);

if (stack_size <= SIZE_MAX - guard_size) {

stack_size += guard_size;

}

assert(is_aligned(stack_size, os::vm_page_size()), "stack_size not aligned");

int status = pthread_attr_setstacksize(&attr, stack_size);

assert_status(status == 0, status, "pthread_attr_setstacksize");

// Configure glibc guard page.

pthread_attr_setguardsize(&attr, os::Linux::default_guard_size(thr_type));

...

pthread_t tid;

// 创建并启动线程

int ret = pthread_create(&tid, &attr, (void* (*)(void*)) thread_native_entry, thread);

...

}

这个函数比较长,这里就省略部分,只保留和线程创建启动相关的部分。可以看到,在 linux 平台上,JVM 的线程是通过大名鼎鼎的 pthread 库来创建启动线程的,这里需要注意下的是,在指定线程栈大小的时候,并不是程序员指定多少就实际是多少的,而是要根据系统平台的限制来综合决定的。

到这里,我们大致上明白了,Java Thread 在底层是对应到一个 pthread 线程。这里有一个问题,就是底层是如果执行我们指定的 run 方法的呢?我们先看下创建并且启动线程的这一行:

pthread_t tid;

// 创建并启动线程

int ret = pthread_create(&tid, &attr, (void* (*)(void*)) thread_native_entry, thread);

这里通过 pthread_create 来创建并且启动线程,我们看下这个接口的定义:

int

pthread_create(pthread_t *thread, const pthread_attr_t *attr, void *(*start_routine)(void *), void *arg);

第一个是 pthread_t 结构体数据指针,存放线程信息的,第二个是线程的属性,第三个是线程体,也就是线程实际执行的函数,第四个是线程体的参数列表。

上面调用这个接口的地方,我们指定了线程体函数是 thread_native_entry,参数是 thread 指针。我们先看下 thread_native_entry 这个函数的定义:

// Thread start routine for all newly created threads

static void *thread_native_entry(Thread *thread) {

...

// call one more level start routine

thread->run();

...

}

同样地,这里省略了很多代码,只保留的重点代码。通过注释我们可以知道,thread->run() 这一行是最可能执行我们 run 方法的地方。所以问题的重点是,thread 指针指向了谁?并且 run 函数的实现是怎样的?我们知道 thread 指针是我们传递进来的,因此通过往回寻找代码我们发现在创建线程的时候我们执行了如下调用(如果你还记得的话):

os::create_thread(this, thr_type, stack_sz);

这里我们将 thread 指针赋值为 this,this 就是 JavaThread 对象,还记得吗?我们前面就是通过创建 JavaThread 对象来创建和启动线程的。所以,我们现在看下 JavaThread 类的 run 函数:

// The first routine called by a new Java thread

void JavaThread::run() {

...

// We call another function to do the rest so we are sure that the stack addresses used

// from there will be lower than the stack base just computed

thread_main_inner();

}

这里重点是调用了 thread_main_inner 函数:

void JavaThread::thread_main_inner() {

assert(JavaThread::current() == this, "sanity check");

assert(this->threadObj() != NULL, "just checking");

// Execute thread entry point unless this thread has a pending exception

// or has been stopped before starting.

// Note: Due to JVM_StopThread we can have pending exceptions already!

if (!this->has_pending_exception() &&

!java_lang_Thread::is_stillborn(this->threadObj())) {

{

ResourceMark rm(this);

this->set_native_thread_name(this->get_thread_name());

}

HandleMark hm(this);

// 这里开始调用 java thread 的 run 方法啦~~~

this->entry_point()(this, this);

}

DTRACE_THREAD_PROBE(stop, this);

// java 中的 run 方法执行完毕了,这里需要退出线程并清理资源

this->exit(false);

// delete cpp 的对象

this->smr_delete();

}

这里就是我们的函数执行体了!!Java Thread 中的 run 方法是在 this->entry_point()(this, this); 这里调用的。看这里的调用方式就知道,entry_point() 返回的是一个函数指针,然后直接执行了调用。entry_point 函数实现如下:

ThreadFunction entry_point() const { return _entry_point; }

这里直接放回了 _entry_point 的 ThreadFunction 类型指针,ThreadFunction 类型其实就是函数指针:

typedef void (*ThreadFunction)(JavaThread*, TRAPS);

因此,重点就是这里的 _entry_point 是哪里赋值的?这里就需要提到前面埋下的一个坑,在创建 JavaThread 对象的时候,我们传递了一个函数指针 thread_entry:

native_thread = new JavaThread(&thread_entry, sz);

现在我们在来看 JavaThread 中对 thread_entry 的处理:

JavaThread::JavaThread(ThreadFunction entry_point, size_t stack_sz) :

Thread() {

...

set_entry_point(entry_point);

...

}

ok,看到这里,我们明白了上面我们需要寻找的 _entry_point 其实就是 thread_entry 指针!

现在看下 thread_entry 指针指向的函数:

static void thread_entry(JavaThread* thread, TRAPS) {

HandleMark hm(THREAD);

Handle obj(THREAD, thread->threadObj());

JavaValue result(T_VOID);

JavaCalls::call_virtual(&result,

obj,

SystemDictionary::Thread_klass(),

vmSymbols::run_method_name(),

vmSymbols::void_method_signature(),

THREAD);

}

这里就是调用我们 java 中 run 方法的地方,但是好像不能很直观的看出来。我们需要解释一下 call_virtual 函数调用的几个参数,第一个是存放函数执行结果的,因为java Thread 中的 run 是 void 型的,所以不必关心;第二个是 java thread object 对象;第三个是 java Thread class 对象;第四个就是我们 run 方法的名称,其实就是字符串“run”,第五个是方法的签名,最后一个是当前执行线程的宏,通过这个宏可以获得到当前执行线程的指针,指向 JavaThread 对象。现在我们首先看下 run_method_name 定义:

#define VM_SYMBOL_DECLARE(name, ignore) \

static Symbol* name() { \

return _symbols[VM_SYMBOL_ENUM_NAME(name)]; \

}

VM_SYMBOLS_DO(VM_SYMBOL_DECLARE, VM_SYMBOL_DECLARE)

#undef VM_SYMBOL_DECLARE

这里是通过宏定义的方式指定的,我们直接搜索这个宏扩展的地方:

template(run_method_name, "run") \

这里通过 cpp 模版方式定义,现在我们知道了 run_method_name 这个宏定义展开之后会变成 “run” 的 Symbol 指针。同时 void_method_signature 可以看到定义:

template(void_method_signature, "()V") \

这里就是 public void run() 方法的签名啦~

好的,现在我们知道了参数的信息,至于 call_virtual 函数是怎样调用到 java 方法的,这里我只能说是通过 JVM call_stub 函数指针指向的指针函数跳转到 vtable 实现的。关于 call_stub 实现机制,是 JVM 中非常复杂的一个独立模块,这个模块涉及到 Java 中众多 invoke* 类的字节码执行细节逻辑。这些内容绝对不是一篇文章能够讲完的,因此这里挖一个坑后面专门写文介绍这块的实现(剧透一下,内容涉及汇编,不过只是简单的几条汇编),如果你急于了解这块的内容,可以参考 HotSpot 技术专家的文章。好吧,又挖了一个坑~

到这里,我们梳理清楚了 java 中 thread 的创建和启动过程,以及 run 方法执行的过程。下面总结下:

Java 线程创建和启动过程如下:

java_lang_Thread->JNI:start0

JNI->JavaThread:new

JavaThread->os:create_thread

os->os_linux:pthread_create

os_linux->JavaThread:thread_entry

JavaThread->java_lang_Thread:run

synchronized 锁优化介绍

synchronized简介

Java中提供了两种实现同步的基础语义:synchronized方法和synchronized块, 我们来看个demo:

public class SyncTest {

public void syncBlock(){

synchronized (this){

System.out.println("hello block");

}

}

public synchronized void syncMethod(){

System.out.println("hello method");

}

}

当SyncTest.java被编译成class文件的时候,synchronized关键字和synchronized方法的字节码略有不同,我们可以用javap -v 命令查看class文件对应的JVM字节码信息,部分信息如下:

{

public void syncBlock();

descriptor: ()V

flags: ACC_PUBLIC

Code:

stack=2, locals=3, args_size=1

0: aload_0

1: dup

2: astore_1

3: monitorenter // monitorenter指令进入同步块

4: getstatic #2 // Field java/lang/System.out:Ljava/io/PrintStream;

7: ldc #3 // String hello block

9: invokevirtual #4 // Method java/io/PrintStream.println:(Ljava/lang/String;)V

12: aload_1

13: monitorexit // monitorexit指令退出同步块

14: goto 22

17: astore_2

18: aload_1

19: monitorexit // monitorexit指令退出同步块

20: aload_2

21: athrow

22: return

Exception table:

from to target type

4 14 17 any

17 20 17 any

public synchronized void syncMethod();

descriptor: ()V

flags: ACC_PUBLIC, ACC_SYNCHRONIZED //添加了ACC_SYNCHRONIZED标记

Code:

stack=2, locals=1, args_size=1

0: getstatic #2 // Field java/lang/System.out:Ljava/io/PrintStream;

3: ldc #5 // String hello method

5: invokevirtual #4 // Method java/io/PrintStream.println:(Ljava/lang/String;)V

8: return

}

从上面的中文注释处可以看到,对于synchronized关键字而言,javac在编译时,会生成对应的monitorenter和monitorexit指令分别对应synchronized同步块的进入和退出,有两个monitorexit指令的原因是:为了保证抛异常的情况下也能释放锁,所以javac为同步代码块添加了一个隐式的try-finally,在finally中会调用monitorexit命令释放锁。而对于synchronized方法而言,javac为其生成了一个ACC_SYNCHRONIZED关键字,在JVM进行方法调用时,发现调用的方法被ACC_SYNCHRONIZED修饰,则会先尝试获得锁。

在JVM底层,对于这两种synchronized语义的实现大致相同,在后文中会选择一种进行详细分析。

所以我们想要探索 synchronized 的实现机制,就需要探索 monitorenter 和monitorexit 指令的执行过程了~

在OpenJDK源码中定位synchronized

我们知道,在 HotSpot JVM 早期的时候,使用了字节码解释器(bytecodeInterpreter),用C++实现了每条JVM指令(如monitorenter、invokevirtual等),但是这种方式效率低下。这里插个内容,你知道为啥这种方式效率低下呢?JVM 也是通过 C/C++ 来编写的,为啥效率就那么慢呢?其实所谓效率低下,在 CPU 层面其实就是一个本来很简单的功能却需要大量的 CPU 机器指令来完成,从而导致效率低下。但是,我们还要问,为啥一个简单的功能会产生很多的机器指令呢?原因是这样,Java 程序编译之后,会产生很多字节码指令,每一个字节码指令在 JVM 底层执行的时候又会变成一堆 C 代码的执行,这一堆 C 代码在编译之后又会变成很多的机器指令,这样一来,我们的 java 代码最终到机器指令一层,所产生的机器指令将是指数级的,因此就导致了 Java 执行效率非常低下,话说这个帽子貌似现在还在~

如果我们仔细思考下,怎么优化这个问题呢?字节码是肯定不能动的,因为 JVM 的一处编写,到处运行的梦想就是靠它完成的。其实,我们会发现,问题的根本就在于 Java 和机器指令之间隔了一层 C/C++,而例如 GCC 之类的编译器又不能做到绝对的智能编译,所产生的机器码效率仍然不是非常高。因此,我们会想,能不能跳过 C/C++ 这个层次能,直接将 java 字节码和本地机器码进行一个对应呢?是的!可以的!HotSpot 工程师们早就想到了,因此早期的字节码解释器很快就被废弃了,转而采用模板解释器(templateInterpreter)。什么是模板解释器,顾名思义,模版就是将一个 java 字节码通过「人工手动」的方式编写为固定模式的机器指令,这部分不在需要 GCC 的帮助,这样就可以大大减少最终需要执行的机器指令,所以才能提高效率。 所谓模版,就是定义了字节码到机器码转化的统一方式,就像生活中的模板一样,执行字节码的时候套用模版就能得到对应的「人工」调优的机器码~说到这里,真是要感叹,JVM 的字节码执行调优过程真是「人工」智能的结果啊!

上面我们向大家解释了,现代 HotSpot JVM 中采用模板解释器,而不是字节码解释器的原因以及基本的技术方案。现在我们就要从 OpenJDK 中的模版解释器中探索 monitorenter 和 monitorexit 指令执行的细节过程。

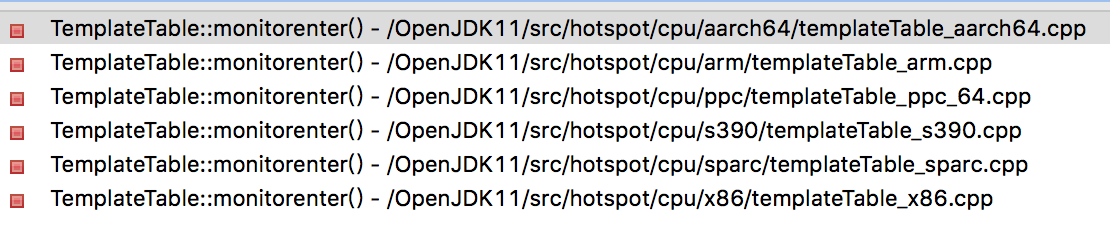

在 OpenJDK 11 的源码中,所有 JVM 的解释器(包括最古老的原始解释器)都在:src/hotspot/share/interpreter 目录下,通过这个目录下的代码文件名称我们就很容易地找到模版解释器的代码位置:templateInterpreter.cpp。通过分析这里的实现,我们知道,其实字节码对应到机器码的模版是在 templateTable.cpp 中定义的,这个文件中的代码量不多,全是字节码对应到本地机器码的实现逻辑,这里我们只是放上 monitor 相关的内容:

def(Bytecodes::_monitorenter , ____|disp|clvm|____, atos, vtos, monitorenter , _ );

def(Bytecodes::_monitorexit , ____|____|clvm|____, atos, vtos, monitorexit , _ );

这里的每一列的含义,在代码中都有说明,这里我们只要知道 monitorenter 函数和 monitorexit 函数就是对应字节码的机器码模版的位置,首先我们看下 monitorenter 的实现:

因为,实际的机器码是和 CPU 相关的,因此 JVM 提供给了几乎所有主流 CPU 的对应版本。这里我们依然看最主流的 x86 的实现templateTable_x86_64.cpp(下面要看汇编了,是不是有点激动,但是不要慌,JVM 针对汇编的调用已经做了非常完备的封装,以至于下面的代码看起来和普通的 C 代码没啥区别):

// Stack layout:

//

// [expressions ] <--- rsp = expression stack top

// ..

// [expressions ]

// [monitor entry] <--- monitor block top = expression stack bot

// ..

// [monitor entry]

// [frame data ] <--- monitor block bot

// ...

// [saved rbp ] <--- rbp

void TemplateTable::monitorenter() {

// 被锁对象(lockee)不能为空

__ null_check(rax);

...

// 从底至顶遍历线程栈(栈结构如上面注释),寻找一个空闲的Lock Record,并保存至c_rarg1

{

Label entry, loop, exit; //声明三个Label

__ movptr(c_rarg3, monitor_block_top); //声明栈顶指针

__ lea(c_rarg2, monitor_block_bot); //声明栈底指针

...

__ bind(loop);// 绑定循环头,用于下面跳转回来

// 检查这个Lock Record是否已使用

__ cmpptr(Address(c_rarg3, BasicObjectLock::obj_offset_in_bytes()), (int32_t) NULL_WORD);

// 若未使用就记录至c_rarg1

__ cmov(Assembler::equal, c_rarg1, c_rarg3);

// 检查Lock Record的_obj属性是否就是被锁对象(lockee)

__ cmpptr(rax, Address(c_rarg3, BasicObjectLock::obj_offset_in_bytes()));

// 是的话代表这是锁重入,就跳转到exit标签,停止搜索

__ jccb(Assembler::equal, exit);

// 否则指针移向向下一个Lock Record

__ addptr(c_rarg3, entry_size);

__ bind(entry);

// 检查是否到栈顶了

__ cmpptr(c_rarg3, c_rarg2);

__ jcc(Assembler::notEqual, loop);//没到底就跳转回loop标签,继续循环

/*结束*/

__ bind(exit);

}

__ testptr(c_rarg1, c_rarg1); // 检查是否找到了空闲的Lock Record

__ jcc(Assembler::notZero, allocated); // 如果找到,跳转到allocated中继续

// 若没有找到,就扩容并分配一个:

{

Label entry, loop;

// 1. 计算新的指针(扩容 // rsp: old expression stack top

__ movptr(c_rarg1, monitor_block_bot); // c_rarg1: old expression stack bottom

__ subptr(rsp, entry_size); // move expression stack top

__ subptr(c_rarg1, entry_size); // move expression stack bottom

__ mov(c_rarg3, rsp); // set start value for copy loop

__ movptr(monitor_block_bot, c_rarg1); // set new monitor block bottom

__ jmp(entry);

// 2. 移动操作栈(expression stack)内容到新位置

__ bind(loop);

__ movptr(c_rarg2, Address(c_rarg3, entry_size)); // load expression stack

// word from old location

__ movptr(Address(c_rarg3, 0), c_rarg2); // and store it at new location

__ addptr(c_rarg3, wordSize); // advance to next word

__ bind(entry);

__ cmpptr(c_rarg3, c_rarg1); // check if bottom reached

__ jcc(Assembler::notEqual, loop); // if not at bottom then

// copy next word

}

// 执行到这说明已经找到空闲Lock Record,保存在c_rarg1中

__ bind(allocated);

...

// 将被锁对象(lockee)存放至空闲Lock Record中

__ movptr(Address(c_rarg1, BasicObjectLock::obj_offset_in_bytes()), rax);

// 跳转执行 lock_object 函数

__ lock_object(c_rarg1);

...

}

函数中出现的bind(slow_case)和bind(done),有何作用?

看看它的声明:

// Label functions void bind(Label& L); // binds an unbound label L to the current code position其实是用来将当前代码的位置绑定到一个Label中的,这样程序就能通过这个label跳转到这段代码执行(相当于汇编中的LABEL伪指令)。

这里我们仍然只给出重点代码部分,代码先在线程栈中寻找一个空闲的Lock Record(即BasicObjectLock对象),然后将被锁对象(即synchronized关键字中的参数)赋值给这个BasicObjectLock对象的_obj属性,最后跳转执行 lock_object 函数。

这里的BasicObjectLock用于保存特定的Java对象与基本锁的关联关系,在JVM运行时,BasicObjectLock对象(Lock Record)将放置在Java栈的栈帧中。它包含两个成员:_lock与_obj:

// A BasicObjectLock associates a specific Java object with a BasicLock.

// It is currently embedded in an interpreter frame.

...

class BasicObjectLock VALUE_OBJ_CLASS_SPEC {

friend class VMStructs;

private:

BasicLock _lock; // the lock, must be double word aligned

oop _obj; // object holds the lock;

...

}

BasicLock类型的_lock表示锁,它内部维护着displaced_header字段,用于备份对象头部的Mark Word(对象相关内容后文会讲解);

class BasicLock VALUE_OBJ_CLASS_SPEC {

friend class VMStructs;

private:

volatile markOop _displaced_header;

...

}

oop类型的_obj,表示持有该锁的Java对象。

接下来继续分析跳转到的 lock_object 函数,同样这个函数也是有不同 CPU 平台实现的,我们还是看 X86 平台的interp_masm_x86_64.cpp:

void InterpreterMacroAssembler::lock_object(Register lock_reg) {

......

// 如果使用重量级锁,直接进入InterpreterRuntime::monitorenter()执行

if (UseHeavyMonitors) {

call_VM(noreg,

CAST_FROM_FN_PTR(address, InterpreterRuntime::monitorenter),

lock_reg);

} else {

......

if (UseBiasedLocking) {

biased_locking_enter(lock_reg, obj_reg, swap_reg, tmp_reg, false, done, &slow_case);

}

......

// Call the runtime routine for slow case

call_VM(noreg,

CAST_FROM_FN_PTR(address, InterpreterRuntime::monitorenter),

lock_reg);

......

// 直接跳到这表明获取锁成功,接下来就会返回到同步代码块里进行字节码的执行了。

}

}

上面的代码只保留了其逻辑结构。其实这里的逻辑很简单,就是根据UseHeavyMonitors以及UseBiasedLocking这两个bool变量决定执行的锁的逻辑,若UseHeavyMonitors为true,就执行InterpreterRuntime::monitorenter逻辑;否则,若UseBiasedLocking为true,就执行biased_locking_enter逻辑。

其实从这个变量的名称就能看出来,UseHeavyMonitors指的是是否使用重量级锁而不进行偏向锁优化,可以通过JVM启动参数-XX:+UseHeavyMonitors来开启;而UseBiasedLocking指的是 JVM 1.6 之后默认使能的偏向锁优化,可以通过JVM启动参数 -XX:+/-UseBiasedLocking 来控制开关。什么?你问我什么是偏向锁?ok,别急,下面我们就要开讲了。

锁的几种形式

传统的锁(也就是下文要说的重量级锁)依赖于系统的同步函数,在linux上使用mutex互斥锁,最底层实现依赖于futex,关于futex可以看这篇文章,这些同步函数都涉及到用户态和内核态的切换、进程的上下文切换,成本较高。对于加了synchronized关键字但运行时并没有多线程竞争,或两个线程接近于交替执行的情况,使用传统锁机制无疑效率是会比较低的。

在JDK 1.6之前,synchronized只有传统的锁机制,因此给开发者留下了synchronized关键字相比于其他同步机制性能不好的印象。

在JDK 1.6引入了两种新型锁机制:偏向锁和轻量级锁,它们的引入是为了解决在没有多线程竞争或基本没有竞争的场景下因使用传统锁机制带来的性能开销问题。

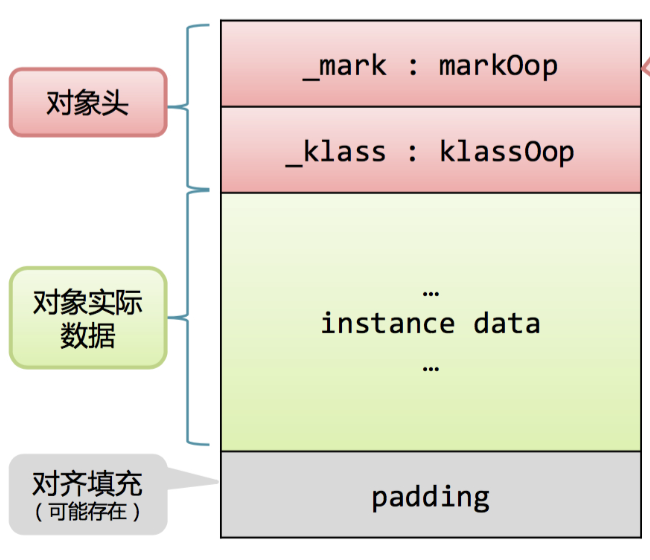

在看这几种锁机制的实现前,我们先来了解下对象头,它是实现上面图中多种锁机制的基础。

对象头

Java 对象在内存的结构基本上分为:对象头和对象体,其中对象头存储对象特征信息,对象体存放对象数据部分。对于普通对象而言,其对象头中又有两类信息:mark word和类型指针。另外对于数组而言还会有一份记录数组长度的数据。

为何使用对象头存放锁信息?

因为在Java中任意对象都可以用作锁,因此必定要有一个映射关系,存储该对象以及其对应的锁信息(比如当前哪个线程持有锁,哪些线程在等待)。一种很直观的方法是,用一个全局map,来存储这个映射关系,但这样会有一些问题:需要对map做线程安全保障,不同的synchronized之间会相互影响,性能差;另外当同步对象较多时,该map可能会占用比较多的内存。

所以最好的办法是将这个映射关系存储在对象头中,因为对象头本身也有一些hashcode、GC相关的数据,所以如果能将锁信息与这些信息共存在对象头中就好了。

那么我们除了研究 JVM 源代码获取 java 对象内存布局之外,还有什么办法得知对象的内存布局呢?有的,在 OpenJDK 工程中,有一个子工程叫做:jol,全名是:java object layout,是的就是 java 对象布局的意思。这是一个工具库,通过这个库可以获取 JVM 中对象布局信息,下面我们展示一个简单的例子(这也是官方给的例子):

public class JOLTest {

public static void main(String[] args) {

System.out.println(VM.current().details());

System.out.println(ClassLayout.parseClass(A.class).toPrintable());

}

public static class A {

boolean f;

}

}

这里通过 JOL 的接口来获取类 A 的对象内存布局,执行之后输出如下内容:

# Running 64-bit HotSpot VM.

# Using compressed oop with 3-bit shift.

# Using compressed klass with 3-bit shift.

# WARNING | Compressed references base/shifts are guessed by the experiment!

# WARNING | Therefore, computed addresses are just guesses, and ARE NOT RELIABLE.

# WARNING | Make sure to attach Serviceability Agent to get the reliable addresses.

# Objects are 8 bytes aligned.

# Field sizes by type: 4, 1, 1, 2, 2, 4, 4, 8, 8 [bytes]

# Array element sizes: 4, 1, 1, 2, 2, 4, 4, 8, 8 [bytes]

JOLTest$A object internals:

OFFSET SIZE TYPE DESCRIPTION VALUE

0 12 (object header) N/A

12 1 boolean A.f N/A

13 3 (loss due to the next object alignment)

Instance size: 16 bytes

Space losses: 0 bytes internal + 3 bytes external = 3 bytes total

这里我们看到输出了很多信息,上面我们类 A 的对象布局如下:12 byte 的对象头 + 1 byte 的对象体 + 3 byte 的填充部分。下面我们分别简要说明下:

对象头:从 JVM 的代码中我们可以看出一个对象的头部定义:

volatile markOop _mark;

union _metadata {

Klass* _klass;

narrowKlass _compressed_klass;

} _metadata;

可以看到分为两部分:第一部分就是 mark 部分,官方称之为 mark word,第二个是 klass 的类型指针,指向这个对象的类对象。这里的 mark word 长度是一个系统字长,在 64 bit 系统上就是 8 个字节,从上面的日志中我们可以看到虚拟机默认使能了 compressed klass,因此第二部分的 union 其实就是 narrowKlass 类型的,如果我们继续看下 narrowKlass 的定义就知道这是个 32 bit 的 unsigned int 类型,因此将占用 4 个字节,所以对象的头部长度整体为 12 字节。

对象体:因为 A 类只定义了一个字段,是 boolean 类型的,在 JVM 底层占用一个字节的长度

填充部分:上面的对象头和对象体长度的总和为 13 字节,因为 JVM 的内存是以 8 字节长度对齐的,因此这里需要填充 3 个字节的长度是的整体的长度等于 16 字节

上面我们说明了下一个 java 对象的内存布局,上面我们展示的是 JVM 启用了 oop 压缩技术的结果,你可以通过 -XX:-UseCompressedOops 来关闭它,关闭之后的布局如下图(这是标准的内存布局):

下面回到我们的话题,我们重点需要关注的是对象的头部定义。上面我们看到,对象的头部总共可以分为两个部分:第一个是 mark word ,用于存储对象自身运行时的数据,如 hash code、GC 分代年龄、锁状态等信息,他是实现偏向锁的关键;第二个是类型指针,是指向该对象所属类对象的指针。

考虑到虚拟机的空间效率,mark word 被设计成一个非固定数据结构以便在极小的空间内存储尽量多的信息,它会根据对象的状态复用自己的存储空间,即它的存储格式是不固定的。在 JVM 中,mark word 内存布局定义在 /src/hotspot/share/oops/markOop.hpp 中,在这个文件的注释中清晰地说明了在 32bit 和 64bit 系统中对象不同状态下的 mark word 布局:

// 32 bits:

// --------

// hash:25 ------------>| age:4 biased_lock:1 lock:2 (normal object)

// JavaThread*:23 epoch:2 age:4 biased_lock:1 lock:2 (biased object)

// size:32 ------------------------------------------>| (CMS free block)

// PromotedObject*:29 ---------->| promo_bits:3 ----->| (CMS promoted object)

//

// 64 bits:

// --------

// unused:25 hash:31 -->| unused:1 age:4 biased_lock:1 lock:2 (normal object)

// JavaThread*:54 epoch:2 unused:1 age:4 biased_lock:1 lock:2 (biased object)

// PromotedObject*:61 --------------------->| promo_bits:3 ----->| (CMS promoted object)

// size:64 ----------------------------------------------------->| (CMS free block)

//

// unused:25 hash:31 -->| cms_free:1 age:4 biased_lock:1 lock:2 (COOPs && normal object)

// JavaThread*:54 epoch:2 cms_free:1 age:4 biased_lock:1 lock:2 (COOPs && biased object)

// narrowOop:32 unused:24 cms_free:1 unused:4 promo_bits:3 ----->| (COOPs && CMS promoted object)

// unused:21 size:35 -->| cms_free:1 unused:7 ------------------>| (COOPs && CMS free block)

...

// [JavaThread* | epoch | age | 1 | 01] lock is biased toward given thread

// [0 | epoch | age | 1 | 01] lock is anonymously biased

//

// - the two lock bits are used to describe three states: locked/unlocked and monitor.

//

// [ptr | 00] locked ptr points to real header on stack

// [header | 0 | 01] unlocked regular object header

// [ptr | 10] monitor inflated lock (header is wapped out)

// [ptr | 11] marked used by markSweep to mark an object

// not valid at any other time

可以看到锁信息也是存在于对象的mark word中的。当对象状态为偏向锁(biased)时,mark word存储的是偏向的线程ID;当状态为轻量级锁(lightweight locked)时,mark word存储的是指向线程栈中Lock Record的指针;当状态为重量级锁(inflated)时,为指向堆中的monitor对象的指针。总结如下(64位):

|------------------------------------------------------------------------------|--------------------|

| Mark Word (64 bits) | State |

|------------------------------------------------------------------------------|--------------------|

| unused:25 | identity_hashcode:31 | unused:1 | age:4 | biased_lock:0 | lock:01| 正常(无锁) |

|------------------------------------------------------------------------------|--------------------|

| thread:54(全0) | epoch:2 | unused:1 | age:4 | biased_lock:1 | lock:01| 匿名偏向 |

|------------------------------------------------------------------------------|--------------------|

| thread:54 | epoch:2 | unused:1 | age:4 | biased_lock:1 | lock:01| 偏向锁 |

|------------------------------------------------------------------------------|--------------------|

| ptr_to_lock_record:62 | lock:00| 轻量级锁 |

|------------------------------------------------------------------------------|--------------------|

| ptr_to_heavyweight_monitor:62 | lock:10| 重量级锁 |

|------------------------------------------------------------------------------|--------------------|

| | lock:11| GC标记 |

|------------------------------------------------------------------------------|--------------------|

偏向锁与锁优化介绍

在JDK1.6中为了提高一个对象在一段很长的时间内都只被一个线程用做锁对象场景下的性能,引入了偏向锁。所谓偏向,就是偏向某一个线程的意思,也就是说这个锁首先假设自己被偏向的线程持有。在单个线程连续持有锁的时候,偏向锁就起作用了。如果一个线程连续不停滴获取锁,那么获取的过程中如果没有发生竞态,那么可以跳过繁重的同步过程,直接就获得锁执行,这样可以大大提高性能。偏向锁是 JDK 1.6 中引入的一项锁优化手段,它的目的就是提高一个对象在一段很长的时间内都只被一个线程用做锁对象场景下的性能,在第一次获得锁时,会有一个CAS操作,之后该线程再获取锁,只会执行几个简单的命令,而不是开销相对较大的CAS命令。

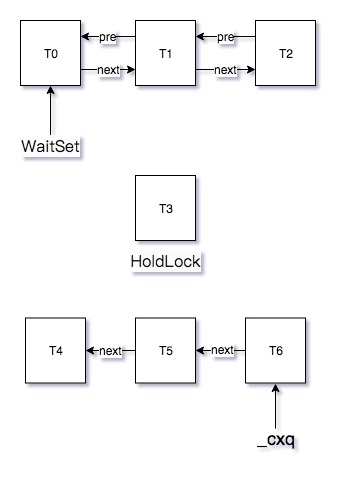

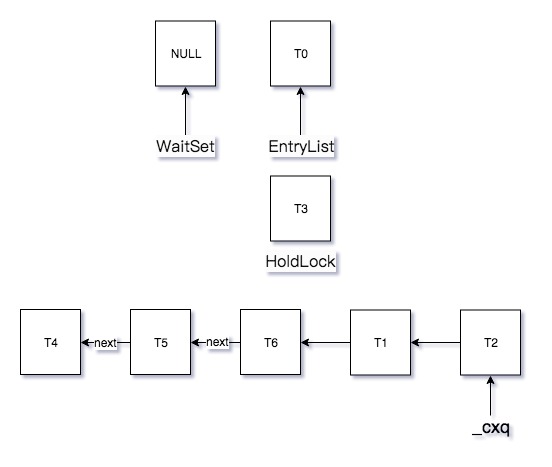

我们来看看偏向锁是如何做的。为了方便解释,这里引用OpenJDK 官方 wiki中的锁优化的原理图:

这张图乍一看,很复杂,你可能看不懂。但是,相信我,如果你仔细看完下文的代码分析并且自己结合 JVM 源码尝试理解,你肯定会完全吃透这张图。下面开始分析这张图。

synchronized锁优化过程

对象创建

在 JVM 6 以上版本中,当新创建一个对象的时候,如果该对象所属的class没有关闭偏向锁模式(什么时候会关闭一个class的偏向模式下文会说,默认所有class的偏向模式都是是开启的),那新创建对象的mark word将是可偏向状态,即使用上图中左边的逻辑。此时mark word中的thread id(参见上文匿名偏向状态下的mark word格式)为0,表示未偏向任何线程,也叫做匿名偏向(anonymously biased)。

加锁过程

这个时候如果有个线程来获取这个对象锁,那么就直接进入已偏向状态,在64位的JVM中,这个状态和未偏向状态的差别就是原来开头的 25 bit 的 unused 与 31bit 的 hash code 变成了 54 bit 的 thread 指针和 2 bit 的分代信息,看起来hashCode与偏向锁冲突了?其实,如果一个对象请求计算identity hashcode,那么将导致它不能被偏向锁锁定,后面我们会在代码中看到这一点。经过这一步的操作,我们就在对象头部存储上了线程指针信息,标记这个对象的锁已经被这个线程持有了,相当于表明:此花已有主。下次当这个线程在此获取这个锁的时候,只要状态没有发生变化,所需要的开销就是一次指针的比较运算,而这个运算是非常轻量的。

但是在某个线程持有这个对象锁的时候,如果有另外一个线程来竞争了,锁的偏向状态结束,会触发撤销偏向的逻辑,这个时候可以分为如下两个情况(先持有锁的线程称为 线程 A,后持有锁的称为 线程 B):

- 线程 B 到达的时候,线程 A 已经放开对象锁:运行线程A时持有的锁为 偏向锁;运行B线程时持有的锁为 轻量级锁

- 线程 B 到达的时候,线程 A 正持有这个锁:运行线程A时持有的锁为 偏向锁;运行B线程时持有的锁为 重量级锁

以上两种情况的操作是不同的,下面分别讲述。

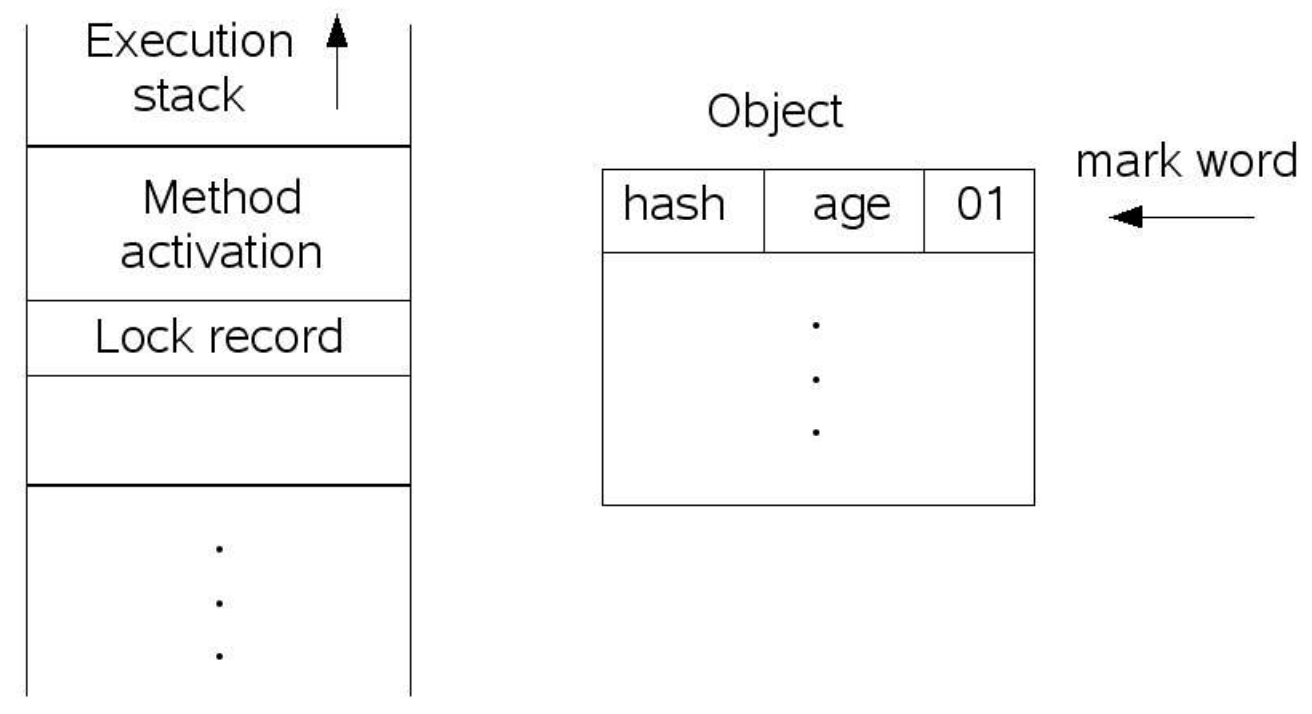

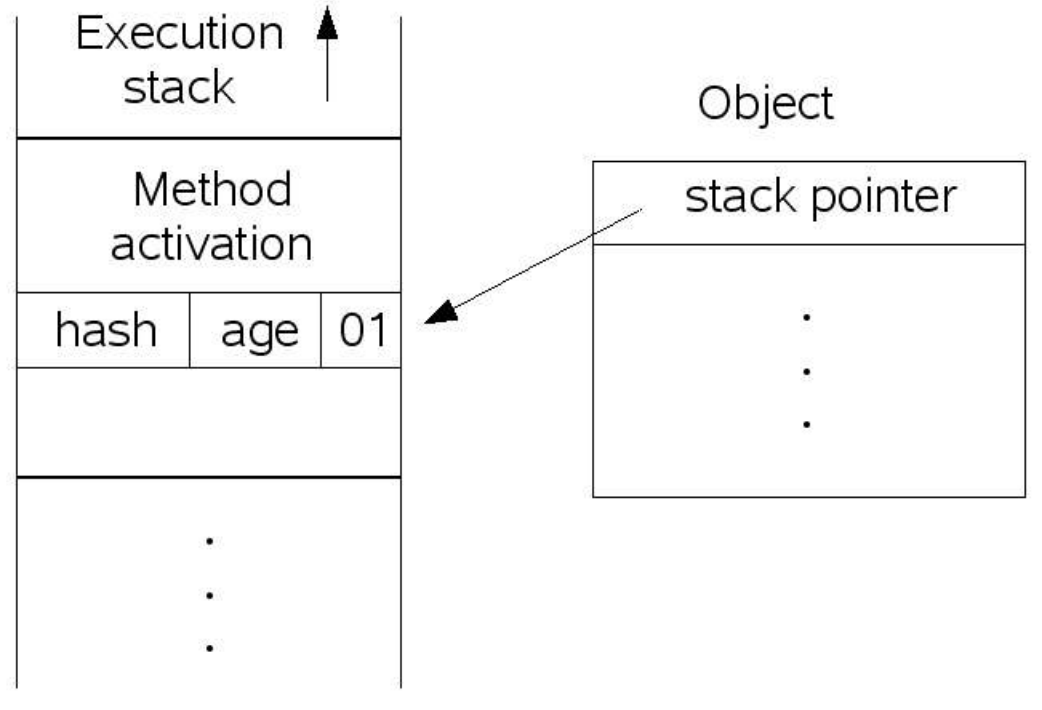

第一种情况,当线程B到达同步代码块时,由于对象的状态是偏向锁,因此首先将对象状态置为不可偏向对象并且未锁定。然后在线程的栈空间新建一个 lock record 的空间,用于存储对象目前的 mark word 的拷贝,然后虚拟机将使用 CAS 操作尝试将对象的 mark word 更新指向 lock record 空间。如果这个更新成功了,那么这个线程就拥有了该对象的锁,并且 mark word 的锁标志位变成 00,表示当前对象锁处于轻量级锁定状态,这个过程如下图所示(上图是锁定前,下图是锁定后):

第二种情况,就是当前对象正在处于锁定状态,这个时候仍然会升级为轻量级锁定对象,但是此时线程 B 获取轻量级锁会失败,因此这个对象锁会进行「膨胀」操作,彻底成为一个重量级的锁。

总结起来的话,就是没有竞争就是偏向锁,少量竞争就是轻量级锁,大量竞争就是重量级锁。

需要说明的是,偏向锁和轻量级锁的关系并不是互相取代或者竞争关系,而是属于在不同情况下的不同的锁优化手段。这里就需要提到在概念上的锁分类,通常可以分为:悲观锁和乐观锁。所谓悲观锁,就是认为如果我不做充分的同步的手段(包括执行重量级的操作)就肯定会出现问题;所谓乐观锁,就是会乐观地预估系统当前的状态,认为状态是符合预期的,因此不用重量级的同步也可以完成同步,如果不巧发生了竞态,就退避,然后再按照一定的策略重试。在 java 中,很多传统的同步方式(包括 synchronized,重入锁)都是悲观锁,在 java 9 中在 Thread 类中新加入了一个接口 onSpinWait 就是一种乐观锁,另外在 JUC 中很多的原子工具类都使用到了 CAS(Compare And Swap)操作,这种操作本质上是利用 CPU 提供的特定原子操作指令,基于冲突检测的方式来实现的一种乐观锁定的同步技术。

上面我们详细介绍了 JVM 中的各种锁优化的技术细节,现在我们看下在 JVM 的代码实现上是如何操作的。我们回到之前对代码的分析。

synchronized的底层代码分析

获得偏向锁

void InterpreterMacroAssembler::lock_object(Register lock_reg) {

......

// 如果使用重量级锁,直接进入InterpreterRuntime::monitorenter()执行

if (UseHeavyMonitors) {

call_VM(noreg,

CAST_FROM_FN_PTR(address, InterpreterRuntime::monitorenter),

lock_reg);

} else {

Label done;

// cmpxchg其实就是CAS操作,必须使用rax寄存器作为老数据的存储。

const Register swap_reg = rax; // Must use rax for cmpxchg instruction

const Register tmp_reg = rbx; // Will be passed to biased_locking_enter to avoid a problematic case where tmp_reg = no_reg.

const Register obj_reg = LP64_ONLY(c_rarg3) NOT_LP64(rcx); // Will contain the oop

......

Label slow_case;

// Load object pointer into obj_reg

movptr(obj_reg, Address(lock_reg, obj_offset));

//如果虚拟机参数允许使用偏向锁,那么进入biased_locking_enter()中

if (UseBiasedLocking) {

// lock_reg :存储的是分配的BasicObjectLock的指针

// obj_reg :存储的是锁对象的指针

// slow_case :即InterpreterRuntime::monitorenter();

// done :标志着获取锁成功。

// slow_case 和 done 也被传入,这样在biased_locking_enter()中,就可以根据情况跳到这两处了。

biased_locking_enter(lock_reg, obj_reg, swap_reg, tmp_reg, false, done, &slow_case);

}

// Load immediate 1 into swap_reg %rax,

movptr(swap_reg, (int32_t)1);

// Load (object->mark() | 1) into swap_reg %rax,

orptr(swap_reg, Address(obj_reg, 0));

// Save (object->mark() | 1) into BasicLock's displaced header

movptr(Address(lock_reg, mark_offset), swap_reg);

...

cmpxchgptr(lock_reg, Address(obj_reg, 0));

jcc(Assembler::zero, done);

// Test if the oopMark is an obvious stack pointer, i.e.,

// 1) (mark & 3) == 0, and

// 2) rsp <= mark < mark + os::pagesize()

//

// These 3 tests can be done by evaluating the following

// expression: ((mark - rsp) & (3 - os::vm_page_size())),

// assuming both stack pointer and pagesize have their

// least significant 2 bits clear.

// NOTE: the oopMark is in swap_reg %rax, as the result of cmpxchg

subptr(swap_reg, rsp);

andptr(swap_reg, 3 - os::vm_page_size());

// Save the test result, for recursive case, the result is zero

movptr(Address(lock_reg, mark_offset), swap_reg);

jcc(Assembler::zero, done);

// 如果使用重量级锁,直接跳到这,需要进入InterpreterRuntime::monitorenter()中去获取锁。

bind(slow_case);

// Call the runtime routine for slow case

call_VM(noreg,

CAST_FROM_FN_PTR(address, InterpreterRuntime::monitorenter),

lock_reg);

// 直接跳到这表明获取锁成功,接下来就会返回进行同步块内字节码的执行了。

bind(done);

}

}

上面的代码,在原始的代码基础上有删减,保留了核心关键逻辑。前文提到了,这里根据UseHeavyMonitors以及UseBiasedLocking这两个bool变量决定执行的锁的逻辑,若UseHeavyMonitors为true,就执行InterpreterRuntime::monitorenter()逻辑;否则,若UseBiasedLocking为true,就执行biased_locking_enter()逻辑。由于JDK1.6后默认开启偏向锁优化,因此线程会执行biased_locking_enter()获取偏向锁。

在调用biased_locking_enter时,slow_case 和 done 标签也被传入,这样在biased_locking_enter中,就可以根据情况回跳到这两处了:比如说获取偏向锁失败,需要跳回时,slow_case进行锁升级;或者成功获取偏向锁,返回done处,继续执行方法的字节码。

biased_locking_enter(...)用于获取偏向锁,代码比较长,下面将一步步分析。macroAssembler_x86.cpp

1. 判断锁对象是否为可偏向状态

// mark_addr:锁对象头中的markOop指针。

Address mark_addr (obj_reg, oopDesc::mark_offset_in_bytes());

NOT_LP64( Address saved_mark_addr(lock_reg, 0); )

if (PrintBiasedLockingStatistics && counters == NULL) {

counters = BiasedLocking::counters();

}

Label cas_label;

int null_check_offset = -1;

// 如果swap_reg中没存mark_addr,那么就先将mark_addr存入swap_reg中。

if (!swap_reg_contains_mark) {

null_check_offset = offset();

movptr(swap_reg, mark_addr);

}

// 将对象的mark_addr,即markOop指针移入tmp_reg中

movptr(tmp_reg, swap_reg);

// 将tmp_reg和biased_lock_mask_in_place进行与操作,

// biased_lock_mask_in_place为111,和它进行与就可以取出markOop中后三位,

// 即(是否偏向锁+锁标志位)

andptr(tmp_reg, markOopDesc::biased_lock_mask_in_place);

// 将上面结果,即(是否偏向锁+锁标志位)和biased_lock_pattern再次比较(biased_lock_pattern为5,即101),

// 如果不相等,则表明不为可偏向状态,需要进行CAS操作,跳往cas_label(在该函数最后return处),

// 交回lock_object中处理;否则即为可偏向状态,接着往下走。

cmpptr(tmp_reg, markOopDesc::biased_lock_pattern);

jcc(Assembler::notEqual, cas_label);

对于上文的A、B线程例子的的情况一:线程A将继续执行下面步骤获取偏向锁;由于假设B在A释放锁后进入同步代码块,此时被锁对象处于可偏向状态(见后文,其实偏向锁的释放没有改变mark word),故B也继续执行下面步骤。

2. 判断锁对象是否已经偏向当前线程

走到这,表明锁对象已经为偏向锁态,需要判断锁对象是否已经偏向当前线程。

// 将锁对象所属类的prototype_header移动至tmp_reg中,prototype_header中存储的也是markOop。

// prototype_header是专门为偏向锁打造的,初始时类的prototype_header为偏向锁态,即后三位为101,一旦发生了bulk_revoke,那么就会设为无锁态,即001。

// bulk_revoke为批量撤销,每次类发生bulk_rebais时(类的所有对象重设偏向锁),

// 类prototype_header中的epoch就会+1,当epoch达到一个阈值时,

// 就会发生bulk_revoke,撤销该类每个对象的偏向锁,这样该类的所有对象以后都不能使用偏向锁了,

// 其实也就是虚拟机认为该对象不适合偏向锁。

load_prototype_header(tmp_reg, obj_reg);

// 构造一个新的markOop:

// 将当前线程id和类的prototype_header相或,

// 这样得到的markOop为(当前线程id + prototype_header中的(epoch + 分代年龄 + 偏向锁标志 + 锁标志位)),

// 注意prototype_header的分代年龄那4个字节为0

orptr(tmp_reg, r15_thread);

// 将上面构造的新markOop与锁对象的markOop进行异或,tmp_reg中相等的位全部被置为0,只剩下不相等的位。

xorptr(tmp_reg, swap_reg);

Register header_reg = tmp_reg;

// 对((int) markOopDesc::age_mask_in_place)进行按位取反,age_mask_in_place为...0001111000,

// 取反后,变成了...1110000111,除了分代年龄那4位,其他位全为1;

// 将取反后的结果再与header_reg相与,这样就把header_reg中除了分代年龄之外的其他位取了出来,

// 即将上面异或得到的结果中分代年龄给忽略掉。

andptr(header_reg, ~((int) markOopDesc::age_mask_in_place));

// 如果除了分代年龄,对象的markOop和(当前线程id+其他位)相等,那么上面与操作的结果应该为0,

// 表明对象之前已经偏向当前线程,即markOop中存放有当前线程id,那么跳到done处,直接进入同步代码块执行即可;

// 否则表明当前线程还不是偏向锁的持有者,会接着往下走。

jcc(Assembler::equal, done);

对于A、B线程例子的的情况一,A线程进入时由于还未偏向,接着执行;线程B进入时,由于对象并不是偏向当前B线程自己(见后文,其实偏向锁的释放没有改变mark word,故markOop的线程ID还是A),因此也是继续执行。

3. 判断是否需要撤销锁对象的偏向

走到这,表明锁对象是可偏向状态但并没有偏向当前线程,接下来判断是否需要撤销锁对象的偏向。

// test指令使header_reg(前面的异或结果)和biased_lock_mask_in_place(即二进制111)进行与运算

testptr(header_reg, markOopDesc::biased_lock_mask_in_place);

// 如果不为0表示 类prototype_header和对象markOop后三位不相等,

// 而能走到这,表明对象markword后三位为101,即偏向模式,

// 因此,test指令结果不为0表明了对象所属类不再支持偏向,发生了bulk_revoke,

// 所以需要对当前对象进行偏向锁的撤销;

// 否则表明目前该类还支持偏向锁,接着往下走。

jccb(Assembler::notZero, try_revoke_bias);

对于A、B线程例子的的情况一,这里假设锁的对象所属于的类依旧支持偏向锁,因此线程A与B都无需撤销重偏向,继续执行。

4. 断当前对象的epoch是否合法

走到这,表明锁对象还支持偏向锁,需要判断当前对象的epoch是否合法,如果不合法,需要取进行重偏向。合法的话接着往下走。

// 测试对象所属类的prototype_header中epoch是否为0,不为0的话则表明之前异或时,

// 类的prototype_header中epoch和对象markOop的epoch不相等,

// 表明类在对象分配后发生过bulk_rebais()(前面提到过,每次发生bulk_rebaise,

// 类的prototype header中的epoch都会+1),

// 所以之前对象的偏向就无效了,需要进行重偏向,转跳到try_rebias标签。否则接着往下走。

testptr(header_reg, markOopDesc::epoch_mask_in_place);

jccb(Assembler::notZero, try_rebias);

对于A、B线程例子的的情况一,仍然假设没有发生bulk_rebais(),故线程A和B都继续执行。

5. 尝试获取偏向锁

走到这,表明锁对象的偏向态合法,可以尝试去获取锁,使对象偏向当前线程。

// 取出对象markOop中除线程id之外的其他位,即代表匿名偏向状态的markOop,放入swap_reg

andptr(swap_reg,

markOopDesc::biased_lock_mask_in_place | markOopDesc::age_mask_in_place | markOopDesc::epoch_mask_in_place);

// 将匿名偏向状态的markOop移动至 tmp_reg,准备构建新的markOop

movptr(tmp_reg, swap_reg);

// 将其他位和当前线程id进行或,构造成一个新的完整的一个字(32bit/64bit)的markOop,存入tmp_reg中。

// 新的markOop因为保存了当前线程id,表示偏向当前线程。

orptr(tmp_reg, r15_thread);

// 尝试利用CAS操作将新构成的markOop存入对象头的mark_addr处,如果设置成功,则获取偏向锁成功。

// 这里说明下,cmpxchgptr操作会强制将rax寄存器(swap_reg)中内容作为老数据,与第二个参数,

// 在这里即mark_addr处的内容进行比较,如果相等(代表原本的markOop就是匿名偏向对象),

// 则将第一个参数的内容,即tmp_reg中的新数据,存入mark_addr。

cmpxchgptr(tmp_reg, mark_addr); // compare tmp_reg and swap_reg

// 上面CAS操作若成功,就完成了偏向锁的获取;

// 上面CAS操作若干失败,表明对象头中的markOop数据已经被篡改,即该锁对象已经偏向其他线程,

// 因为偏向锁不容许多个线程访问同一个锁对象,所以需要跳到slow_case处,去撤销该对象的偏向锁,并进行锁升级。

if (slow_case != NULL) {

// 若成功ZF标志(Zero Flag)被设置,notZero不成立,不跳转,继续执行;

// 反之,跳转到slow_case处

jcc(Assembler::notZero, *slow_case);

}

// 上面CAS成功的情况下,直接就跳往done处,回去执行方法的字节码了。

jmp(done);

对于A、B线程例子的的情况一:对于线程A,此处的cmpxchgptr成功(新构建的markOop与原markOop相同),成功获得偏向锁;而对于后来的线程B,cmpxchgptr失败(见后文,其实偏向锁的释放没有改变mark word,故原markOop的线程ID还是A,因而新构建的markOop与原markOop不同),跳转到slow_case,也就是执行InterpreterRuntime::monitorenter,进行撤销偏向锁。

6. try_rebais和try_revoke

其实到这里,biased_locking_enter()已经结束了,不过上面多处提到了try_rebais和try_revoke,两个Label,它们对应的代码也定义在biased_locking_enter中。

bind(try_rebias);

// 构建一个偏向当前线程的markOop

// 先将锁对象所属类的prototype_header送入tmp_reg。

load_prototype_header(tmp_reg, obj_reg);

// 设置当前线程ID到tmp_reg里,此时markOop为偏向当前线程的markOop

orptr(tmp_reg, r15_thread);

// 尝试用CAS操作,将新建的markOop设置到对象的mark word中

cmpxchgptr(tmp_reg, mark_addr);

// 和第5步一样,如果CAS失败,则表明对象头的markOop数据已经被其他线程更改,

// 需要跳往slow_case进行撤销偏向锁,否则跳往done处,执行字节码。

if (slow_case != NULL) {

jcc(Assembler::notZero, *slow_case);

}

jmp(done);

bind(try_revoke_bias);

// 走到这,表明这个类的prototype_header中已经没有可偏向的位了,

// 即这个类的所有对象都不再支持偏向锁了,但是当前对象仍为可偏向状态,

// 所以我们需要重置下当前对象的markOop为无锁态。

// 将锁对象所属类的prototype_header(无锁态)送入tmp_reg。

load_prototype_header(tmp_reg, obj_reg);

// 尝试用CAS操作,使对象的markOop重置为无锁态。

// 这里是否失败无所谓,即使失败了,也表明其他线程已经移除了对象的偏向锁标志。

cmpxchgptr(tmp_reg, mark_addr);

//接下来会回到lock_object()方法中,继续轻量级锁的获取。

bind(cas_label);

return null_check_offset;

退出偏向锁

注意这里说的退出偏向锁是指释放偏向锁,即退出同步块时的过程,不要与后文的撤销偏向锁混淆。

与monitorenter一样,我们看下monitorexit的实现templateTable_x86_64.cpp:

void TemplateTable::monitorexit() {

...

// 要解锁的被锁对象(lockee)不能为空

__ null_check(rax);

...

// 从底至顶遍历线程栈,寻找关联要解锁的被锁对象(lockee)的Lock Record,存放到c_rarg1

{

...

__ movptr(c_rarg1, monitor_block_top); //声明栈顶指针

__ lea(c_rarg2, monitor_block_bot); //声明栈底指针

...

__ bind(loop);// 绑定循环头,用于下面跳转回来

// 检查这个Lock Record关联的是否是要解锁的被锁对象(lockee)

__ cmpptr(rax, Address(c_rarg1, BasicObjectLock::obj_offset_in_bytes()));

// 如果是的话停止搜索,跳转到found标签

__ jcc(Assembler::equal, found);

// 否则指针移向向下一个Lock Record

__ addptr(c_rarg1, entry_size);

...

// 检查是否到栈顶了

__ cmpptr(c_rarg1, c_rarg2);

//没到底就跳转回loop标签,继续循环

__ jcc(Assembler::notEqual, loop);

}

// 若没找到就抛异常

// error handling. Unlocking was not block-structured

__ call_VM(noreg, CAST_FROM_FN_PTR(address,

InterpreterRuntime::throw_illegal_monitor_state_exception));

__ should_not_reach_here();

...

__ bind(found);

__ push_ptr(rax); // make sure object is on stack (contract with oopMaps)

// 跳转执行 unlock_object 函数,此时c_rarg1存放的是该锁对象的Lock Record

__ unlock_object(c_rarg1);

__ pop_ptr(rax); // discard object

}

注意unlock_object函数中传入的寄存器lock_reg中存放的是该锁对象的Lock Record:

void InterpreterMacroAssembler::unlock_object(Register lock_reg) {

...

// Convert from BasicObjectLock structure to object and BasicLock structure

// 保存BasicObjectLock中的BasicLock地址到swap_reg,

// 下面的cmpxchg指令会对比第二个参数是否与此相同,当相同CAS才成功

lea(swap_reg, Address(lock_reg, BasicObjectLock::lock_offset_in_bytes()));

// 将oop(锁关联对象)存入obj_reg

movptr(obj_reg, Address(lock_reg, BasicObjectLock::obj_offset_in_bytes ()));

// 将BasicObjectLock的关联对象oop设置为NULL,即释放Lock Record

movptr(Address(lock_reg, BasicObjectLock::obj_offset_in_bytes()), NULL_WORD);

//如果开启了偏向锁

if (UseBiasedLocking) {

// 对于偏向锁,会直接跳转到done;

// 对轻量级锁,会继续执行下面的代码

biased_locking_exit(obj_reg, header_reg, done);

}

...

// 如果是递归的情况

testptr(header_reg, header_reg);

// 就直接转跳到done,结束执行

jcc(Assembler::zero, done);

...

// 要将Displaced Mark Word通过CAS设置到对象头的Mark Word

if (os::is_MP()) lock();

cmpxchgptr(header_reg, Address(obj_reg, 0));

// 如果CAS成功了,跳转到done;否则执行InterpreterRuntime::monitorexit

jcc(Assembler::zero, done);

// Call the runtime routine for slow case.

movptr(Address(lock_reg, BasicObjectLock::obj_offset_in_bytes()), obj_reg); // restore obj

call_VM(noreg, CAST_FROM_FN_PTR(address, InterpreterRuntime::monitorexit), lock_reg);

bind(done);

}

void MacroAssembler::biased_locking_exit(Register obj_reg, Register temp_reg, Label& done) {

assert(UseBiasedLocking, "why call this otherwise?");

// Check for biased locking unlock case, which is a no-op

// Note: we do not have to check the thread ID for two reasons.

// First, the interpreter checks for IllegalMonitorStateException at

// a higher level. Second, if the bias was revoked while we held the

// lock, the object could not be rebiased toward another thread, so

// the bias bit would be clear.

movptr(temp_reg, Address(obj_reg, oopDesc::mark_offset_in_bytes()));

andptr(temp_reg, markOopDesc::biased_lock_mask_in_place);

cmpptr(temp_reg, markOopDesc::biased_lock_pattern);

jcc(Assembler::equal, done);

}

如注释所言,这是一个“无操作”的过程(no-op),仅仅检查了对象的对象头是否还是可偏向状态,如果是表明这是偏向锁,于是转到done标签,表示已经退出了使用偏向锁的同步代码块;否则就是轻量级锁,返回继续执行轻量级锁撤销逻辑。

上面的代码结合注释理解起来应该不难,偏向锁的释放很简单,只要将对应Lock Record释放就好了,并不修改mark word。而轻量级锁则需要通过CAS将Displaced Mark Word替换到对象头的mark word中,如果成功就完成了轻量级锁的撤销;如果CAS失败或者是重量级锁则进入到InterpreterRuntime::monitorexit方法中。

撤销偏向

撤销是指在获取偏向锁的过程因为不满足条件导致要将锁对象改为非偏向锁状态。从OpenJDK wiki的那张图我们知道,对于A、B线程例子的的情况一,当后来的B线程获取锁时会撤销对象的偏向锁升级为轻量级锁,下面我们从源码角度先来分析撤销偏向的过程。上文说了,当获取偏向锁失败,线程就会转跳到slow_case处执行 InterpreterRuntime::monitorenter 函数。这个函数不仅仅是模版解释器会调用,解释执行器也会执行这个,所以定义在 InterpreterRuntime 类下:

// Synchronization

//

// The interpreter's synchronization code is factored out so that it can

// be shared by method invocation and synchronized blocks.

//%note synchronization_3

//%note monitor_1

IRT_ENTRY_NO_ASYNC(void, InterpreterRuntime::monitorenter(JavaThread* thread, BasicObjectLock* elem))

Handle h_obj(thread, elem->obj());

if (UseBiasedLocking) {

// Retry fast entry if bias is revoked to avoid unnecessary inflation

ObjectSynchronizer::fast_enter(h_obj, elem->lock(), true, CHECK);

} else {

ObjectSynchronizer::slow_enter(h_obj, elem->lock(), CHECK);

}

IRT_END

因为我们开启了偏向锁优化,因此上面的代码,肯定是执行 fast_enter 啦~下面是 fast_enter 函数的定义:

// Fast Monitor Enter/Exit

// This the fast monitor enter. The interpreter and compiler use

// some assembly copies of this code. Make sure update those code

// if the following function is changed. The implementation is

// extremely sensitive to race condition. Be careful.

void ObjectSynchronizer::fast_enter(Handle obj, BasicLock* lock,

bool attempt_rebias, TRAPS) {

//虚拟机参数判断是否开启了偏向锁

if (UseBiasedLocking) {

//如果不处于全局安全点,即正常的Java线程

if (!SafepointSynchronize::is_at_safepoint()) {

//通过`revoke_and_rebias`这个函数尝试撤销或重偏向偏向锁

BiasedLocking::Condition cond = BiasedLocking::revoke_and_rebias(obj, attempt_rebias, THREAD);

if (cond == BiasedLocking::BIAS_REVOKED_AND_REBIASED) {

return;

}

} else {//如果在安全点,即VM线程,撤销偏向锁

assert(!attempt_rebias, "can not rebias toward VM thread");

BiasedLocking::revoke_at_safepoint(obj);

}

assert(!obj->mark()->has_bias_pattern(), "biases should be revoked by now");

}

slow_enter(obj, lock, THREAD);

}

这里开始还是要判断 UseBiasedLocking,如果是 true 的话,就开始执行优化逻辑,否则会 fall back 到 slow_enter 的。是不是感觉判断 UseBiasedLocking 有点啰嗦?其实不是的,因为这个函数在很多地方都会调用的,因此判断是必要的!

在 fast_enter 函数中,有判断 safepoint 的地方,这里大家先不用关心,这个是和 JVM 的 GC 有关的内容,不是我们这里关心的内容。对于正常的Java线程执行,会执行到 revoke_and_rebias 这个函数中,这个函数比较长,主要是在执行 OpenJDK wiki 中图的 revoke 和 rebias 操作(撤销或者重偏向)。第一个参数封装了锁对象和当前线程,第二个参数代表是否允许重偏向,这里是true。

下面这段代码线程都不会走到,读者可以跳过不看:

BiasedLocking::Condition BiasedLocking::revoke_and_rebias(Handle obj, bool attempt_rebias, TRAPS) {

//1:必须在安全点

assert(!SafepointSynchronize::is_at_safepoint(), "must not be called while at safepoint");

//2:读取对象头

markOop mark = obj->mark();

//is_biased_anonymously()判断mark是否为可偏向状态,即mark的偏向锁标志位为1,锁标志位为 01,线程id为null

//当计算hashCode时,进入此分支,会在一个非全局安全点进行偏向锁撤销(BIAS_REVOKED)

if (mark->is_biased_anonymously() && !attempt_rebias) {

markOop biased_value = mark;

//创建一个非偏向的markword

markOop unbiased_prototype = markOopDesc::prototype()->set_age(mark->age());

//通过cas重新设置偏向锁状态

markOop res_mark = (markOop) Atomic::cmpxchg_ptr(unbiased_prototype, obj->mark_addr(), mark);

//如果CAS成功,返回偏向锁撤销状态

if (res_mark == biased_value) {

return BIAS_REVOKED;

}

} else if (mark->has_bias_pattern()) {

//如果锁对象为可偏向状态(biased_lock:1, lock:01,不管线程id是否为空),尝试重新偏向

Klass* k = obj->klass();

markOop prototype_header = k->prototype_header();

//如果对应class关闭了偏向模式,则取消偏向锁操作

if (!prototype_header->has_bias_pattern()) {

// This object has a stale bias from before the bulk revocation

// for this data type occurred. It's pointless to update the

// heuristics at this point so simply update the header with a

// CAS. If we fail this race, the object's bias has been revoked

// by another thread so we simply return and let the caller deal

// with it.

markOop biased_value = mark;

//CAS 更新对象头markword为非偏向锁

markOop res_mark = (markOop) Atomic::cmpxchg_ptr(prototype_header, obj->mark_addr(), mark);

assert(!(*(obj->mark_addr()))->has_bias_pattern(), "even if we raced, should still be revoked");

return BIAS_REVOKED;

} else if (prototype_header->bias_epoch() != mark->bias_epoch()) {//如果偏向锁epoch过期,则进入当前分支

//如果允许尝试重新偏向

if (attempt_rebias) {

assert(THREAD->is_Java_thread(), "");

markOop biased_value = mark;

//构建新的偏向本线程的markOop,设置好本线程的 ThreadID 、分代年龄、epoch值

markOop rebiased_prototype = markOopDesc::encode((JavaThread*) THREAD, mark->age(), prototype_header->bias_epoch());

//通过CAS 操作, 将尝试新markOop写入对象头中

markOop res_mark = (markOop) Atomic::cmpxchg_ptr(rebiased_prototype, obj->mark_addr(), mark);

//CAS成功,则返回撤销和重新偏向状态

if (res_mark == biased_value) {

return BIAS_REVOKED_AND_REBIASED;

}

} else {

//不尝试获取偏向锁,则取消偏向锁

markOop biased_value = mark;

markOop unbiased_prototype = markOopDesc::prototype()->set_age(mark->age());

markOop res_mark = (markOop) Atomic::cmpxchg_ptr(unbiased_prototype, obj->mark_addr(), mark);

//如果CAS操作成功,返回偏向锁撤销状态

if (res_mark == biased_value) {

return BIAS_REVOKED;

}

}

}

}

...

}

前文提到,若对象计算并保存了hashCode到对象的Mark Word中,无法保存偏向锁信息,会导致该对象无法被偏向锁锁定,Oracle这篇文章就有说到。而且,如果该对象已经偏向,如果如果我们没有重写默认的hashCode方法,默认的hashCode要通过

ObjectSynchronizer::FastHashCode函数计算identity hashcode,该函数会调用revoke_and_rebias,这将导致偏向锁的撤销。intptr_t ObjectSynchronizer::FastHashCode (Thread * Self, oop obj) { if (UseBiasedLocking) { // 如果是可偏向状态 if (obj->mark()->has_bias_pattern()) { ... BiasedLocking::revoke_and_rebias(hobj, false, JavaThread::current()); ...通过

FastHashCode实现我们发现,调用revoke_and_rebias时会进入if (mark->is_biased_anonymously() && !attempt_rebias)分支,从而撤销偏向锁。读者可以自行编写代码验证。

言归正传,fast_enter函数中调用了上述函数,其实是进入下面的代码,继续执行后面的重偏向与撤销的逻辑。

//...接上一段代码

//重偏向与撤销的逻辑

//通过启发式的方式决定到底是执行撤销还是执行重偏向

HeuristicsResult heuristics = update_heuristics(obj(), attempt_rebias);

if (heuristics == HR_NOT_BIASED) {//决定不偏向

return NOT_BIASED;

} else if (heuristics == HR_SINGLE_REVOKE) {//决定撤销单个线程

...

if (mark->biased_locker() == THREAD &&

prototype_header->bias_epoch() == mark->bias_epoch()) {//需要撤销的是偏向当前线程的锁,当调用Object#hashcode方法时会走到这一步

// 撤销逻辑1...

...

return cond;

} else {

// 撤销逻辑2...

...

return revoke.status_code();

}

}

...

//批量撤销、批量重偏向的逻辑...

...

return bulk_revoke.status_code();

代码逻辑很简单,就是通过通过启发式(Heuristics)的方式决定到底是执行撤销还是执行重偏向。我们先来看看这个启发式策略update_heuristics():

//启发式的方式决定要做哪种操作

static HeuristicsResult update_heuristics(oop o, bool allow_rebias) {

markOop mark = o->mark();

if (!mark->has_bias_pattern()) {

//不可偏向直接返回

return HR_NOT_BIASED;

}

//控制撤销的次数

// Heuristics to attempt to throttle the number of revocations.

// Stages:

// 1. Revoke the biases of all objects in the heap of this type,

// but allow rebiasing of those objects if unlocked.

// 2. Revoke the biases of all objects in the heap of this type

// and don't allow rebiasing of these objects. Disable

// allocation of objects of that type with the bias bit set.

// 锁对象的类

Klass* k = o->klass();

// 当前时间

jlong cur_time = os::javaTimeMillis();

// 该类上一次批量撤销的时间

jlong last_bulk_revocation_time = k->last_biased_lock_bulk_revocation_time();

// 该类偏向锁撤销的次数

int revocation_count = k->biased_lock_revocation_count();

//定义在globs.hpp,

//BiasedLockingBulkRebiasThreshold(重偏向阈值,默认值为20),

//BiasedLockingBulkRevokeThreshold(批量撤销阈值,默认值为40),

//BiasedLockingDecayTime(开启一次新的批量重偏向距离上次批量重偏向的后的延迟时间,默认值为25000,

//也就是开启批量重偏向后,经过了一段较长的时间(>=BiasedLockingDecayTime),撤销计数器才超过阈值,那我们会重置计数器。),

//这些值可通过JVM启动参数改变

if ((revocation_count >= BiasedLockingBulkRebiasThreshold) &&

(revocation_count < BiasedLockingBulkRevokeThreshold) &&

(last_bulk_revocation_time != 0) &&

(cur_time - last_bulk_revocation_time >= BiasedLockingDecayTime)) {

// This is the first revocation we've seen in a while of an

// object of this type since the last time we performed a bulk

// rebiasing operation. The application is allocating objects in

// bulk which are biased toward a thread and then handing them

// off to another thread. We can cope with this allocation

// pattern via the bulk rebiasing mechanism so we reset the

// klass's revocation count rather than allow it to increase

// monotonically. If we see the need to perform another bulk

// rebias operation later, we will, and if subsequently we see

// many more revocation operations in a short period of time we

// will completely disable biasing for this type.

//在执行了一定时间之内,执行的撤销次数没有超过阈值,那么认为可以优先执行bulk rebias,因此将计数回归原始值

k->set_biased_lock_revocation_count(0);

revocation_count = 0;

}

// Make revocation count saturate just beyond BiasedLockingBulkRevokeThreshold

if (revocation_count <= BiasedLockingBulkRevokeThreshold) {

//对执行撤销的次数进行计数

revocation_count = k->atomic_incr_biased_lock_revocation_count();

}

if (revocation_count == BiasedLockingBulkRevokeThreshold) {

//如果达到批量撤销阈值则返回HR_BULK_REVOKE,执行bulk revoke

return HR_BULK_REVOKE;

}

if (revocation_count == BiasedLockingBulkRebiasThreshold) {

//如果达到批量重偏向阈值则返回HR_BULK_REBIAS,执行bulk rebias

return HR_BULK_REBIAS;

}

//默认执行单个对象的锁撤销

return HR_SINGLE_REVOKE;

}

通过代码中的注释可以了解到启发式策略的执行逻辑。//TODO…

再回到revoke_and_rebias()中重偏向与撤销的逻辑的分析:

//重偏向与撤销的逻辑

//通过启发式的方式决定到底是执行撤销还是执行重偏向

HeuristicsResult heuristics = update_heuristics(obj(), attempt_rebias);

if (heuristics == HR_NOT_BIASED) {//决定不偏向

return NOT_BIASED;

} else if (heuristics == HR_SINGLE_REVOKE) {//决定撤销单个线程

Klass *k = obj->klass();

markOop prototype_header = k->prototype_header();

if (mark->biased_locker() == THREAD &&

prototype_header->bias_epoch() == mark->bias_epoch()) {// 走到这里说明需要撤销的是偏向当前线程的锁,当调用Object#hashcode方法时会走到这一步

// 因为只要遍历当前线程的栈就好了,所以不需要等到safepoint再撤销。

ResourceMark rm;

if (TraceBiasedLocking) {

tty->print_cr("Revoking bias by walking my own stack:");

}

BiasedLocking::Condition cond = revoke_bias(obj(), false, false, (JavaThread*) THREAD);

((JavaThread*) THREAD)->set_cached_monitor_info(NULL);

assert(cond == BIAS_REVOKED, "why not?");

return cond;

} else {// 下面代码最终会在VM线程中的safepoint调用revoke_bias方法

VM_RevokeBias revoke(&obj, (JavaThread*) THREAD);

VMThread::execute(&revoke);

return revoke.status_code();

}

}

assert((heuristics == HR_BULK_REVOKE) ||

(heuristics == HR_BULK_REBIAS), "?");

//批量撤销、批量重偏向的逻辑

VM_BulkRevokeBias bulk_revoke(&obj, (JavaThread*) THREAD,

(heuristics == HR_BULK_REBIAS),

attempt_rebias);

VMThread::execute(&bulk_revoke);

return bulk_revoke.status_code();

对于情况一,我们假设这是被锁对象头一次发生偏向撤销,因此B线程调用update_heuristics(...)时会返回HR_SINGLE_REVOKE,从而进入else if (heuristics == HR_SINGLE_REVOKE)分支里的else分支,通过调用VMThread::execute(&revoke)最终在VM线程中的safepoint调用revoke_bias方法。

关于VM 线程这里介绍下:在JVM中有个专门的VM Thread,该线程会源源不断的从VMOperationQueue中取出请求,比如GC请求。对于需要safepoint的操作(VM_Operationevaluate_at_safepoint返回true)必须要等到所有的Java线程进入到safepoint才开始执行。关于safepoint可以参考下这篇文章。

void VMThread::execute(VM_Operation* op) {

Thread* t = Thread::current();

//如果不是虚拟机线程,即普通Java线程

if (!t->is_VM_thread()) {

...

// 进行前置处理,根据返回值确定是否继续

if (!op->doit_prologue()) {

return; // op was cancelled

}

...

// Add VM operation to list of waiting threads. We are guaranteed not to block while holding the

// VMOperationQueue_lock, so we can block without a safepoint check. This allows vm operation requests

// to be queued up during a safepoint synchronization.

//添加到VM operation队列等待执行

{

VMOperationQueue_lock->lock_without_safepoint_check();

bool ok = _vm_queue->add(op);

op->set_timestamp(os::javaTimeMillis());

VMOperationQueue_lock->notify();

VMOperationQueue_lock->unlock();

// VM_Operation got skipped

if (!ok) {

assert(concurrent, "can only skip concurrent tasks");

if (op->is_cheap_allocated()) delete op;

return;

}

}

if (execute_epilog) {

// 进行后置处理

op->doit_epilogue();

}

} else {//如果已经是虚拟机线程

// invoked by VM thread; usually nested VM operation

...

op->evaluate();

...

}

}

evaluate()会回调VM_Operation类的doit()虚函数:

// 回调doit()

void VM_Operation::evaluate() {

...

doit();

...

}

VM_RevokeBias继承了VM_Operation并重写了doit_prologue()和doit()两个虚函数,doit()中完成了撤销偏向锁:

// VM_RevokeBias继承了VM_Operation

// 并重写了doit_prologue()和doit()两个虚函数

class VM_RevokeBias : public VM_Operation {

...

public:

...

virtual VMOp_Type type() const { return VMOp_RevokeBias; }

// 如vm_operations.hpp注释描述的,若返回false则取消该VM操作

virtual bool doit_prologue() {

// Verify that there is actual work to do since the callers just

// give us locked object(s). If we don't find any biased objects

// there is nothing to do and we avoid a safepoint.

// 若被锁对象不为空,则返回true继续后续逻辑即通过evaluate()回调doit()

if (_obj != NULL) {

markOop mark = (*_obj)()->mark();

if (mark->has_bias_pattern()) {

return true;

}

} else {

for ( int i = 0 ; i < _objs->length(); i++ ) {

// 遍历被锁对象,若存在可偏向状态,返回true继续后续逻辑即通过evaluate()回调doit()

markOop mark = (_objs->at(i))()->mark();

if (mark->has_bias_pattern()) {

return true;

}

}

}

// 没有可偏向状态,返回true继续后续逻辑即通过evaluate()回调doit()

return false;

}

virtual void doit() {

// 被锁对象不为空

if (_obj != NULL) {

_status_code = revoke_bias((*_obj)(), false, false, _requesting_thread);

...

return;

} else {

...

}

}

BiasedLocking::Condition status_code() const {

return _status_code;

}

};

doit()又调用了revoke_bias,注意第一个参数为锁对象,第2、3个参数为都为false:

static BiasedLocking::Condition revoke_bias(oop obj, bool allow_rebias, bool is_bulk, JavaThread* requesting_thread) {

// 获取对象头

markOop mark = obj->mark();

if (!mark->has_bias_pattern()) {

...

// 不是可偏向状态,返回

return BiasedLocking::NOT_BIASED;

}

uint age = mark->age();

//新建匿名偏向模式(可偏向)的头:分代年龄为age、可偏向(101)状态

markOop biased_prototype = markOopDesc::biased_locking_prototype()->set_age(age);

//新建无锁模式的头:无hash、分代年龄为age、无锁(001)状态

markOop unbiased_prototype = markOopDesc::prototype()->set_age(age);

....

//获取偏向的线程

JavaThread* biased_thread = mark->biased_locker();

if (biased_thread == NULL) {

// Object is anonymously biased. We can get here if, for

// example, we revoke the bias due to an identity hash code

// being computed for an object.

// 没有偏向线程,identity hash code的计算会导致进入此分支

if (!allow_rebias) {

// 设置对象头为前面构建的无锁模式的头:无hash、分代年龄为age、无锁(001)状态

obj->set_mark(unbiased_prototype);

}

// 偏向锁撤销完成

return BiasedLocking::BIAS_REVOKED;

}

// Handle case where the thread toward which the object was biased has exited

//对象头偏向线程是否活着

bool thread_is_alive = false;

if (requesting_thread == biased_thread) {

//当前请求线程 就是 对象头偏向线程,说明偏向线程活着

thread_is_alive = true;

} else {

// 遍历存活线程队列,看看能不能找到对象头偏向线程

for (JavaThread* cur_thread = Threads::first(); cur_thread != NULL; cur_thread = cur_thread->next()) {

if (cur_thread == biased_thread) {

// 能找到说明对象头的偏向线程活着

thread_is_alive = true;

break;

}

}

}

// 如果对象头偏向线程已退出,则撤销偏向锁

if (!thread_is_alive) {

if (allow_rebias) {

// 设置匿名偏向模式(可偏向)的头:分代年龄为age、可偏向(101)状态

obj->set_mark(biased_prototype);

} else {//由于传入该函数的allow_rebias==false,故走此分支

// 设置无锁模式的头:无hash、分代年龄为age、无锁(001)状态

obj->set_mark(unbiased_prototype);

}

// 偏向锁撤销完成

return BiasedLocking::BIAS_REVOKED;

}

// 注释解释了逻辑:

// Thread owning bias is alive.

// Check to see whether it currently owns the lock and, if so,

// write down the needed displaced headers to the thread's stack.

// Otherwise, restore the object's header either to the unlocked

// or unbiased state.

//get_or_compute_monitor_info返回对象头偏向线程的所有的被锁住的对象的监视器信息,

//即线程栈所有的Lock Record

GrowableArray<MonitorInfo*>* cached_monitor_info = get_or_compute_monitor_info(biased_thread);

BasicLock* highest_lock = NULL;

//遍历偏向线程的线程栈的所有Lock Record,寻找当前被锁对象(obj)对应的Lock Record,

//若找到,说明偏向的线程还在执行同步代码块中的代码,需要进行锁膨胀

for (int i = 0; i < cached_monitor_info->length(); i++) {

MonitorInfo* mon_info = cached_monitor_info->at(i);

if (mon_info->owner() == obj) {// 找到了

// Assume recursive case and fix up highest lock later

// 需要锁膨胀,直接修改偏向线程栈中的Lock Record。

// 由于要处理锁重入的case,在这里暂时只将Lock Record的Displaced Mark Word设置为null,

// 其余处理Lock Record会在下面的代码中再进行

markOop mark = markOopDesc::encode((BasicLock*) NULL);

highest_lock = mon_info->lock();

//设置栈中的Displaced Mark Word为NULL

highest_lock->set_displaced_header(mark);

}

...

}

// 如果上面的过程找到了displaced_header,则highest_lock不为空

// 说明当前撤销偏向的对象正在被偏向头里的线程锁定,即还在同步块中,

// 进入下面分支,对正在被锁定的对象进行偏向锁撤销

if (highest_lock != NULL) {

// Fix up highest lock to contain displaced header and point

// object at it

// 如上面注释所言,用unbiased_prototype重新设置线程栈上的displaced header

highest_lock->set_displaced_header(unbiased_prototype);

// Reset object header to point to displaced mark.

// 使对象头(mark)指向这个displaced header

obj->release_set_mark(markOopDesc::encode(highest_lock));

...

//对正在被锁定的对象进行偏向锁撤销完成,并没有改变对象头的锁状态,而是回到fast_enter继续锁膨胀过程

} else {// 如果上面的过程没找displaced_header,说明当前撤销偏向锁

// 的对象目前没有被锁定,即已经不在同步块中了,

// 进入这个分支,对未锁定对象进行偏向撤销

if (allow_rebias) {

//设置为匿名偏向状态

obj->set_mark(biased_prototype);

} else {//由于传入该函数的allow_rebias==false,故走此分支

// Store the unlocked value into the object's header.

obj->set_mark(unbiased_prototype);

//对未锁定对象进行偏向锁撤销完成,也表明对象成为了无锁模式:无hash、分代年龄为age、无锁(001)状态

}

}

// 偏向撤销完成

return BiasedLocking::BIAS_REVOKED;

}

上面revoke_bias方法逻辑:

- 查看偏向的线程是否存活,如果已经不存活了,则直接撤销偏向锁。JVM维护了一个集合存放所有存活的线程,通过遍历该集合判断某个线程是否存活。

- 偏向的线程是否还在同步块中,如果不在了,则撤销偏向锁。我们回顾一下偏向锁的加锁流程:每次进入同步块(即执行monitorenter)的时候都会以从高往低的顺序在栈中找到第一个可用的Lock Record,将其obj字段指向锁对象。每次解锁(即执行monitorexit)的时候都会将最低的一个相关Lock Record移除掉。所以可以通过遍历线程栈中的Lock Record来判断线程是否还在同步块中。

- 将偏向线程所有相关Lock Record的Displaced Mark Word设置为null,然后将最高位的Lock Record的Displaced Mark Word 设置为无锁状态,最高位的Lock Record也就是第一次获得锁时的Lock Record(这里的第一次是指重入获取锁时的第一次),然后将对象头指向最高位的Lock Record,这里不需要用CAS指令,因为是在safepoint。 执行完后,就升级成了轻量级锁。原偏向线程的所有Lock Record都已经变成轻量级锁的状态。

注意,上面函数的调用最终返回值只可能是BiasedLocking::NOT_BIASED或BiasedLocking::BIAS_REVOKED,被返回到顶层的fast_enter的调用,这里重新贴一下代码:

// Fast Monitor Enter/Exit

// This the fast monitor enter. The interpreter and compiler use

// some assembly copies of this code. Make sure update those code

// if the following function is changed. The implementation is

// extremely sensitive to race condition. Be careful.

void ObjectSynchronizer::fast_enter(Handle obj, BasicLock* lock,

bool attempt_rebias, TRAPS) {

//虚拟机参数判断是否开启了偏向锁

if (UseBiasedLocking) {

//如果不处于全局安全点,即正常的Java线程

if (!SafepointSynchronize::is_at_safepoint()) {

//通过`revoke_and_rebias`这个函数尝试撤销或重偏向偏向锁

BiasedLocking::Condition cond = BiasedLocking::revoke_and_rebias(obj, attempt_rebias, THREAD);

if (cond == BiasedLocking::BIAS_REVOKED_AND_REBIASED) {

return;

}

} else {//如果在安全点,即VM线程,撤销偏向锁

assert(!attempt_rebias, "can not rebias toward VM thread");

BiasedLocking::revoke_at_safepoint(obj);

}

assert(!obj->mark()->has_bias_pattern(), "biases should be revoked by now");

}

slow_enter(obj, lock, THREAD);

}

由于返回的cond即BiasedLocking::NOT_BIASED或BiasedLocking::BIAS_REVOKED,不等于BiasedLocking::BIAS_REVOKED_AND_REBIASED (只有在revoke_and_rebias()函数中由于epoch过期执行撤销和重新偏向,才会返回) ,故不返回,继续执行到slow_enter(...)的调用。

升级为轻量级锁

我们来看看 slow_enter 函数:

// Interpreter/Compiler Slow Case

// This routine is used to handle interpreter/compiler slow case

// We don't need to use fast path here, because it must have been

// failed in the interpreter/compiler code.

void ObjectSynchronizer::slow_enter(Handle obj, BasicLock* lock, TRAPS) {

markOop mark = obj->mark();

assert(!mark->has_bias_pattern(), "should not see bias pattern here");

if (mark->is_neutral()) {//如果是无锁状态, markword的biase_lock:0,lock:01

// Anticipate successful CAS -- the ST of the displaced mark must

// be visible <= the ST performed by the CAS.

//通过CAS把mark保存到BasicLock对象的_displaced_header字段

lock->set_displaced_header(mark);

if (mark == obj()->cas_set_mark((markOop) lock, mark)) {

TEVENT(slow_enter: release stacklock);

return;

}

// Fall through to inflate() ...

} else if (mark->has_locker() &&

THREAD->is_lock_owned((address)mark->locker())) {//如果markword处于加锁状态、且markword中的ptr指针指向当前线程的栈帧,表示为轻量级锁重入,不需要争抢锁

assert(lock != mark->locker(), "must not re-lock the same lock");

assert(lock != (BasicLock*)obj->mark(), "don't relock with same BasicLock");

lock->set_displaced_header(NULL);

return;

}

// 这时候需要膨胀为重量级锁,膨胀前,设置Displaced Mark Word为一个特殊值,

// 代表该锁正在用一个重量级锁的monitor

// The object header will never be displaced to this lock,

// so it does not matter what the value is, except that it

// must be non-zero to avoid looking like a re-entrant lock,

// and must not look locked either.

lock->set_displaced_header(markOopDesc::unused_mark());

//先调用inflate膨胀为重量级锁,该方法返回一个ObjectMonitor对象,然后调用其enter方法

ObjectSynchronizer::inflate(THREAD,

obj(),

inflate_cause_monitor_enter)->enter(THREAD);

}

这里的执行逻辑比较简洁,主要执行上面 OpenJDK wiki 中的锁优化逻辑。首先会判断对象锁是否为是无锁状态(中立的(neutral)):

bool is_neutral() const {

// 这里的 biased_lock_mask_in_place 是 7, 即二进制111

// unlocked_value 值是 1

return (mask_bits(value(), biased_lock_mask_in_place) == unlocked_value);

}

这里的判断也是比较简单的,就是将 mark word 中的最后 3 个 bit 进行掩码运算,将得到的值和 1(unlocked_value) 进行比较,如果等于 1 就表示对象是中立的,也就是没有被任何线程锁定,否则就失败。这里需要问一个问题,那就是为什么我们要对 mark word 的最后的 3 个 bit 进行掩码运算?这里我们就需要再次看下在 biase 模式下的对象 mark word 的布局(这里以 64 bit 为例,仍然是上面的 oopDesc 注释描述):

unused:25 hash:31 -->| unused:1 age:4 biased_lock:1 lock:2 (normal object)

JavaThread*:54 epoch:2 unused:1 age:4 biased_lock:1 lock:2 (biased object)

可以看到,无论是普通对象或者是可偏向的对象,最后 3 个 bit 的格式是固定的,我们再次看下上面 OpenJDK wiki 中的锁优化图,会发现在普通对象的时候,也就是 biase revoke 时 unlock 状态下的 header 最后三个 bit 就是 001,也就是十进制的 1!所以这里通过简单高效的二进制运算就获得了对象的锁定状态。

批量重偏向和批量撤销

相关实现在BiasedLocking::revoke_and_rebias中:

BiasedLocking::Condition BiasedLocking::revoke_and_rebias(Handle obj, bool attempt_rebias, TRAPS) {

...

//code 1:重偏向的逻辑

HeuristicsResult heuristics = update_heuristics(obj(), attempt_rebias);

// 非重偏向的逻辑

...

assert((heuristics == HR_BULK_REVOKE) ||

(heuristics == HR_BULK_REBIAS), "?");

//code 2:批量撤销、批量重偏向的逻辑

VM_BulkRevokeBias bulk_revoke(&obj, (JavaThread*) THREAD,

(heuristics == HR_BULK_REBIAS),

attempt_rebias);

VMThread::execute(&bulk_revoke);

return bulk_revoke.status_code();

}

在每次撤销偏向锁的时候都通过update_heuristics方法记录下来,以类为单位,当某个类的对象撤销偏向次数达到一定阈值的时候JVM就认为该类不适合偏向模式或者需要重新偏向另一个对象,update_heuristics就会返回HR_BULK_REVOKE或HR_BULK_REBIAS。进行批量撤销或批量重偏向。

重新贴一遍update_heuristics方法:

//启发式的方式决定要做哪种操作

static HeuristicsResult update_heuristics(oop o, bool allow_rebias) {

markOop mark = o->mark();

if (!mark->has_bias_pattern()) {

//不可偏向直接返回

return HR_NOT_BIASED;

}

//控制撤销的次数

// Heuristics to attempt to throttle the number of revocations.

// Stages:

// 1. Revoke the biases of all objects in the heap of this type,

// but allow rebiasing of those objects if unlocked.

// 2. Revoke the biases of all objects in the heap of this type

// and don't allow rebiasing of these objects. Disable

// allocation of objects of that type with the bias bit set.

// 锁对象的类

Klass* k = o->klass();

// 当前时间

jlong cur_time = os::javaTimeMillis();

// 该类上一次批量撤销的时间

jlong last_bulk_revocation_time = k->last_biased_lock_bulk_revocation_time();

// 该类偏向锁撤销的次数

int revocation_count = k->biased_lock_revocation_count();

//定义在globs.hpp,

//BiasedLockingBulkRebiasThreshold(重偏向阈值,默认值为20),

//BiasedLockingBulkRevokeThreshold(批量撤销阈值,默认值为40),

//BiasedLockingDecayTime(开启一次新的批量重偏向距离上次批量重偏向的后的延迟时间,默认值为25000,

//也就是开启批量重偏向后,经过了一段较长的时间(>=BiasedLockingDecayTime),撤销计数器才超过阈值,那我们会重置计数器。),

//这些值可通过JVM启动参数改变

if ((revocation_count >= BiasedLockingBulkRebiasThreshold) &&

(revocation_count < BiasedLockingBulkRevokeThreshold) &&

(last_bulk_revocation_time != 0) &&

(cur_time - last_bulk_revocation_time >= BiasedLockingDecayTime)) {

// This is the first revocation we've seen in a while of an

// object of this type since the last time we performed a bulk

// rebiasing operation. The application is allocating objects in

// bulk which are biased toward a thread and then handing them

// off to another thread. We can cope with this allocation

// pattern via the bulk rebiasing mechanism so we reset the

// klass's revocation count rather than allow it to increase

// monotonically. If we see the need to perform another bulk

// rebias operation later, we will, and if subsequently we see

// many more revocation operations in a short period of time we

// will completely disable biasing for this type.

//在执行了一定时间之内,执行的撤销次数没有超过阈值,那么认为可以优先执行bulk rebias,因此将计数回归原始值

k->set_biased_lock_revocation_count(0);

revocation_count = 0;

}

// Make revocation count saturate just beyond BiasedLockingBulkRevokeThreshold

if (revocation_count <= BiasedLockingBulkRevokeThreshold) {

//对执行撤销的次数进行计数

revocation_count = k->atomic_incr_biased_lock_revocation_count();

}

if (revocation_count == BiasedLockingBulkRevokeThreshold) {

//如果达到批量撤销阈值则返回HR_BULK_REVOKE,执行bulk revoke

return HR_BULK_REVOKE;

}

if (revocation_count == BiasedLockingBulkRebiasThreshold) {

//如果达到批量重偏向阈值则返回HR_BULK_REBIAS,执行bulk rebias

return HR_BULK_REBIAS;

}

//默认执行单个对象的锁撤销

return HR_SINGLE_REVOKE;

}

当达到阈值的时候就会通过VM 线程在safepoint调用bulk_revoke_or_rebias_at_safepoint, 参数bulk_rebias如果是true代表是批量重偏向否则为批量撤销。attempt_rebias_of_object代表对操作的锁对象o是否运行重偏向,这里是true。

static BiasedLocking::Condition bulk_revoke_or_rebias_at_safepoint(oop o,

bool bulk_rebias,

bool attempt_rebias_of_object,

JavaThread* requesting_thread) {

...

jlong cur_time = os::javaTimeMillis();

o->klass()->set_last_biased_lock_bulk_revocation_time(cur_time);

Klass* k_o = o->klass();

Klass* klass = k_o;

if (bulk_rebias) {

// 批量重偏向的逻辑

if (klass->prototype_header()->has_bias_pattern()) {

// 自增前类中的的epoch

int prev_epoch = klass->prototype_header()->bias_epoch();

// code 1:类中的epoch自增

klass->set_prototype_header(klass->prototype_header()->incr_bias_epoch());

int cur_epoch = klass->prototype_header()->bias_epoch();

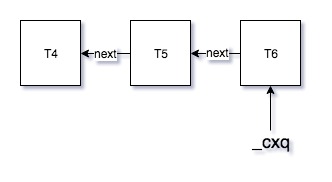

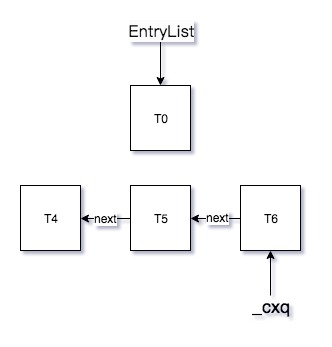

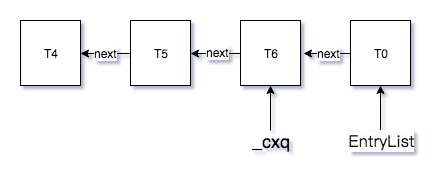

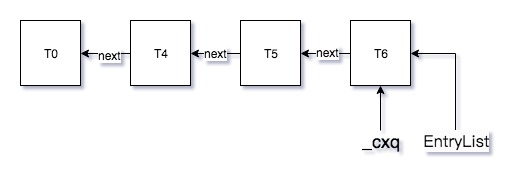

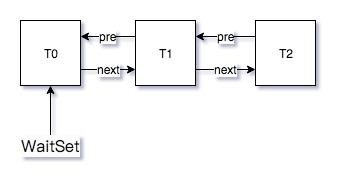

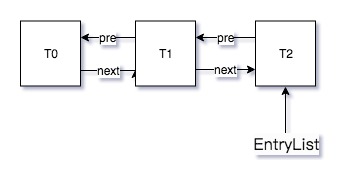

// code 2:遍历所有线程的栈,更新类型为该klass的所有锁实例的epoch